机构名称:

¥ 1.0

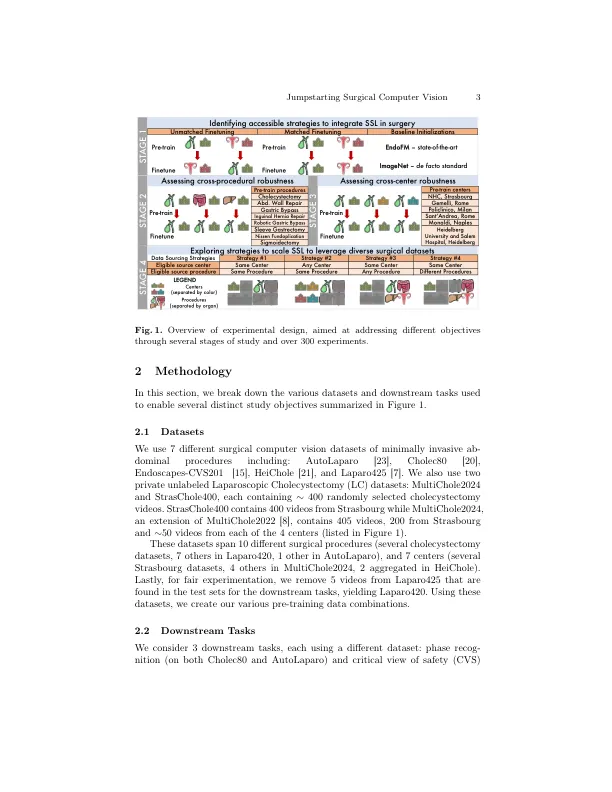

摘要。研究人员和行业之间的共识指出,缺乏大型,代表性的注释数据集是手术数据科学领域进步的最大障碍。自我监督学习(SSL)的进步代表了一个解决方案,通过提供任务不合时宜的初始化来降低对大型标记数据集的依赖。然而,当前的自我监督学习方法对领域转移的鲁棒性尚不清楚,从而限制了我们对利用多种外科数据来源的效用的理解。将焦点从方法转移到数据,我们证明了基于SSL的初始化的下游值与预训练数据集的组成无关紧要。这些结果强调了一个重要的差距,当我们扩展自我监督的方法以构建通用的“ Foun-Dation模型”时,需要填补这一差距,该方法可以在手术领域内进行多种用例。通过受控实验的几个阶段,我们开发了预处理数据集组成的建议,这些数据集组成通过300多个实验,涵盖20个预训练数据集,9个手术程序,7个中心(医院),3个标签DATA设置,3个下游任务以及多次运行。使用此处描述的方法,我们在两个公共基准测试中均优胜于阶段识别的预先培训:cholec80上的2.2%,自动帕拉的培训最高为5.1%。

跳跃手术计算机视觉

主要关键词