机构名称:

¥ 3.0

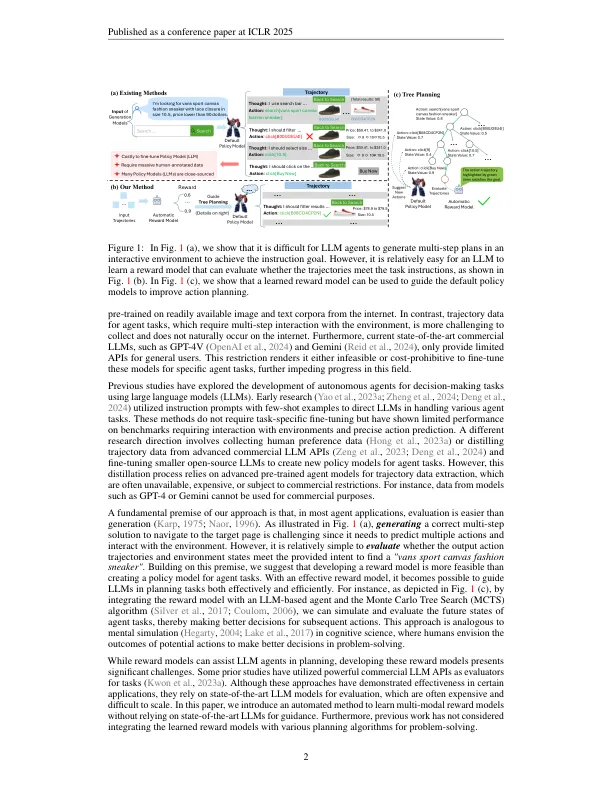

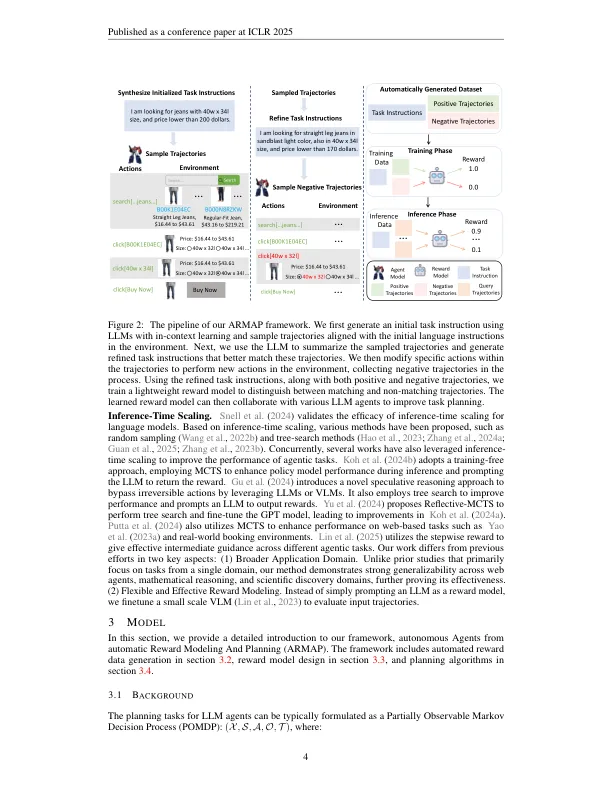

大语言模型(LLMS)在一系列文本生成任务中表现出了显着的功能。但是,LLM仍然在需要多步决策和环境反馈的问题上挣扎,例如在线购物,科学推理和数学问题解决。与纯文本数据不同,收集大规模的决策数据具有挑战性。此外,许多功能强大的LLM只能通过API访问,由于成本和复杂性,这阻碍了对代理任务的微调。为了解决LLM代理的局限性,我们提出了一个框架,该框架可以自动从没有人类注释的环境中学习奖励模型。该模型可用于评估LLM代理的动作轨迹并为任务计划提供启发式方法。具体来说,我们的方法涉及使用一个基于LLM的代理随机浏览环境,从而产生各种动作轨迹。随后,利用单独的LLM来分配任务意图,并与每个轨迹的正确响应合成负面响应。然后将这些三胞胎(任务意图,正面响应和负面响应)用作训练数据,以优化能够评分动作轨迹的奖励模型。此奖励模型可以与基于LLM的代理和各种计划算法集成,以增强任务解决性能。通过对不同代理基准进行的评估来证明我们框架的有效性和概括性。总而言之,我们提出的框架代表了增强LLM代理商的决策能力的重要选择。通过自动化奖励模型的学习,我们克服了数据稀缺和API限制的挑战,可能彻底改变了LLM在复杂和交互式环境中的应用。这项研究为更复杂的AI代理铺平了道路,能够解决需要多步骤决策的各种现实世界中的问题。1

臂章:来自自动

主要关键词