机构名称:

¥ 3.0

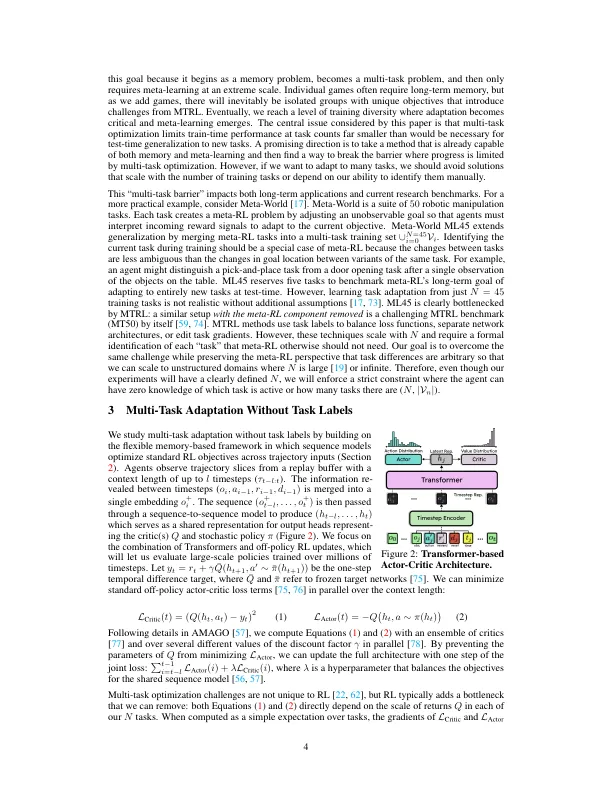

在不同数据集中训练的语言模型通过文本学习解锁概括。增强学习(RL)策略可以通过在序列模型的内存中获得元学习来实现相似的效果。但是,Meta-RL研究主要侧重于适应单个任务的微小变化。在不面对多任务优化挑战的情况下,很难扩展更一般的行为,而很少有解决方案与Meta-RL从大型未标记任务中学习的目标兼容。为了应对这一挑战,我们重新审视了一个想法,即多任务RL被跨不同任务的不平衡返回量表造成的不平衡训练损失所瓶颈。我们建立在基于变压器(内在)元RL的最新进步的基础上,并评估了一个简单但可扩展的解决方案,在该解决方案中,代理人的演员和评论家的目标都转换为分类术语,这些术语将从当前的回报量表中脱离优化。Meta-World ML45,多游戏Procgen,Multi-Task Popgym,Multi-Game Atari和Babyai中的大规模比较发现,这种设计在没有明确任务标签的情况下将在线多任务改编和记忆问题上取得了重大进展。

amago-2:打破元中的多任务屏障...

主要关键词