机构名称:

¥ 1.0

摘要我们提出了一个新型系统,该系统可以在具有上下文意识的游戏中使用大型语言模型(LLM)来增强非播放字符(NPC),从而提供动态,环境敏感的交互。传统上,NPC依靠预先列出的对话和对环境的认识,从而限制了他们对玩家行动的反应。我们的系统通过捕获NPC周围环境的全景图像并应用语义分割来识别对象及其空间位置来解决此问题。我们通过将对象位置与分割信息相结合,从而生成NPC环境的结构化JSON表示。此数据作为LLM提供了上下文,使NPC能够将空间知识纳入与玩家的对话中。结果是更身临其境的游戏玩法,NPC可以在互动过程中参考附近的对象,地标和环境特征,从而增强可信度和参与度。本文讨论了我们系统的技术实施,展示了将视觉感知整合到NPC中如何转换游戏内对话和交互。

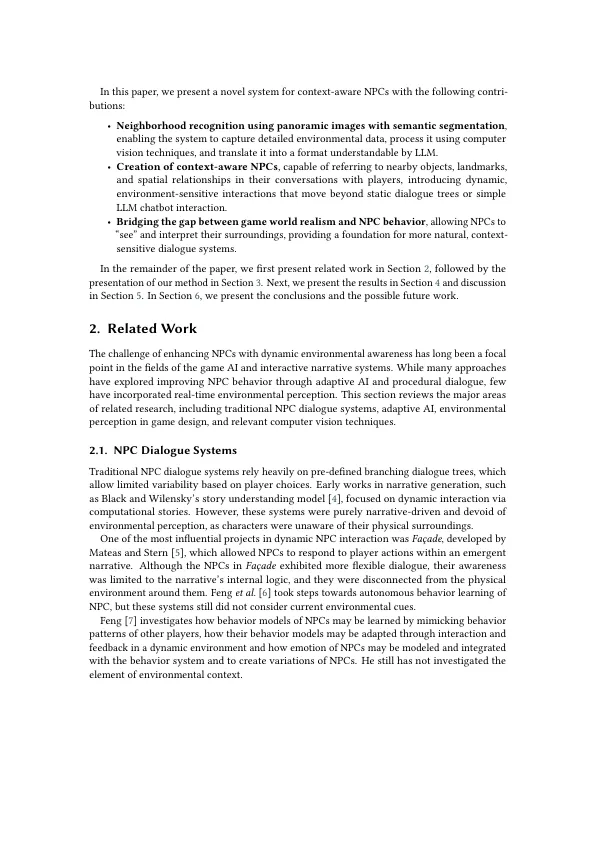

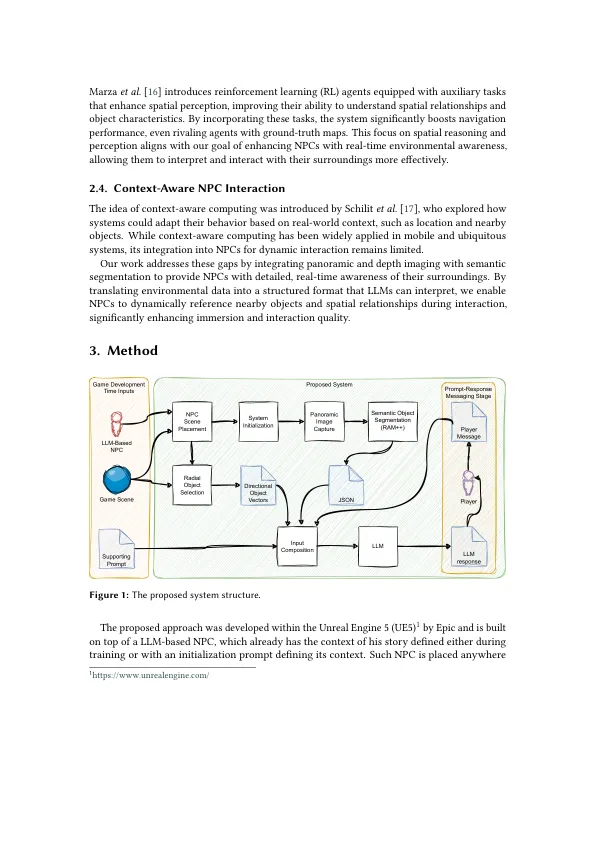

将环境意识整合到NPC