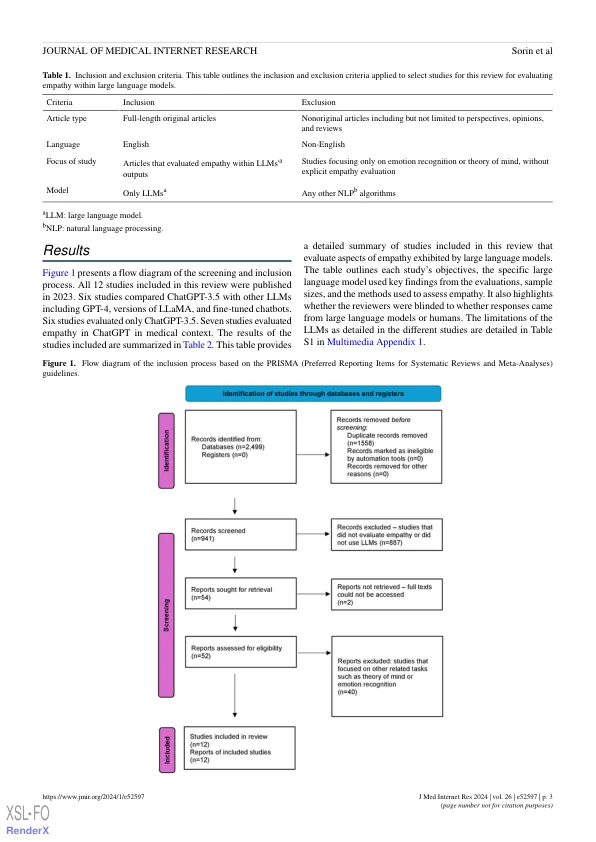

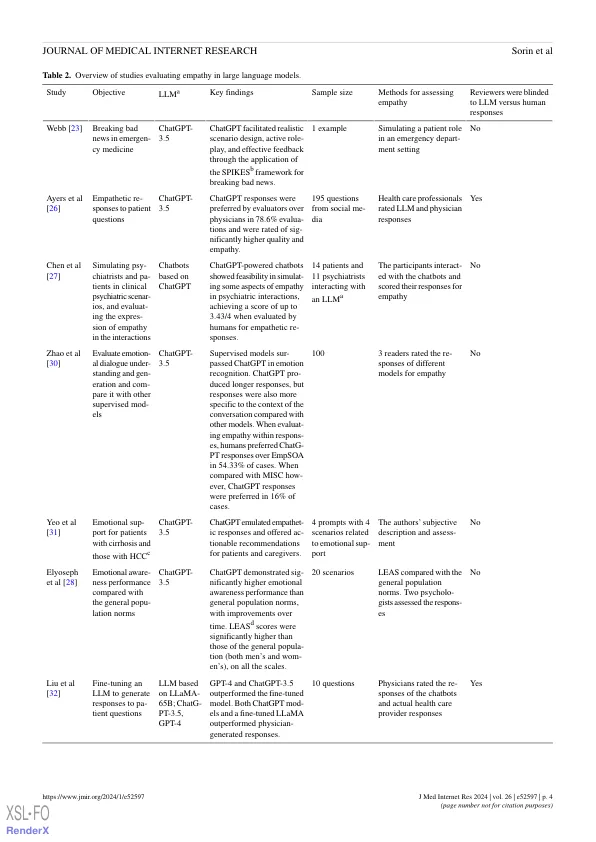

背景:同理心是人类互动的一个基本方面,其特征是体验他人在自己内的情感的能力。在医疗保健中,同理心是医疗保健专业人员和患者互动的基础。对人类来说是一种独特的素质,据信大型语言模型(LLM)缺乏。目标:我们旨在回顾有关LLM在表现同理心能力的文献。方法:我们在2022年12月至2024年2月之间进行了Medline,Google Scholar,Psyarxiv,Medrxiv和Arxiv的文献搜索。我们包括了英语全长出版物,这些出版物评估了LLMS输出中的同理心。我们排除了评估与情绪智力有关的其他主题的论文,这些主题不是特别的同理心。总结了纳入的研究结果,包括所使用的LLM,移情任务中的表现以及模型的局限性以及研究的元数据。结果:2023年发表的总共12项研究符合纳入标准。chatgpt-3.5(OpenAI),其中6项研究与其他LLMS(例如GPT-4,Llama(Meta)和微调聊天机器人)进行了比较。七项研究的重点是在医学环境中的同理心。研究报告说,LLMS表现出同理心的元素,包括情绪识别和在各种情况下的情感支持。评估指标包括自动指标,例如以召回式的研究,用于观察评估和双语评估研究以及人类主观评估。在某些情况下,LLM在与移情相关的任务中的表现要优于人类。一些研究比较了人类的同理心的表现,而另一些研究比较了不同模型之间的同理心。例如,对Chatgpt-3.5的评估是根据社交媒体对患者的问题的回答进行了评估,在78.6%的病例中,Chatgpt的回答比人类的回答比人类的回答更为优先。其他研究使用主观读者的分数。一项研究报告了其微调LLM的平均移情评分为1.84-1.9(比例0-2),而评估基于Chatgpt的聊天机器人的另一项研究报告的人类平均评级为4.43,为4.43分为4.43。其他评估是基于情感意识量表的水平,据报道,Chatgpt-3.5的水平高于人类。另一项研究在美国医疗许可检查中评估了Chatgpt和GPT-4关于软技能问题的问题,其中GPT-4正确回答了90%的问题。的局限性,包括重复使用移情短语,遵循初始说明的难度,过长的响应,对提示的敏感性以及受评估者背景影响的总体主观评估指标。结论:LLM表现出认知同理心的要素,识别情绪并在各种情况下提供情感支持的反应。由于社交技能是智力不可或缺的一部分,因此这些进步使LLM更接近类似人类的互动,并扩大其在需要情商的应用中的潜在用途。但是,这些模型的性能以及用于评估软技能的评估策略的余地。

大型语言模型和同理心:系统评价

主要关键词