机构名称:

¥ 2.0

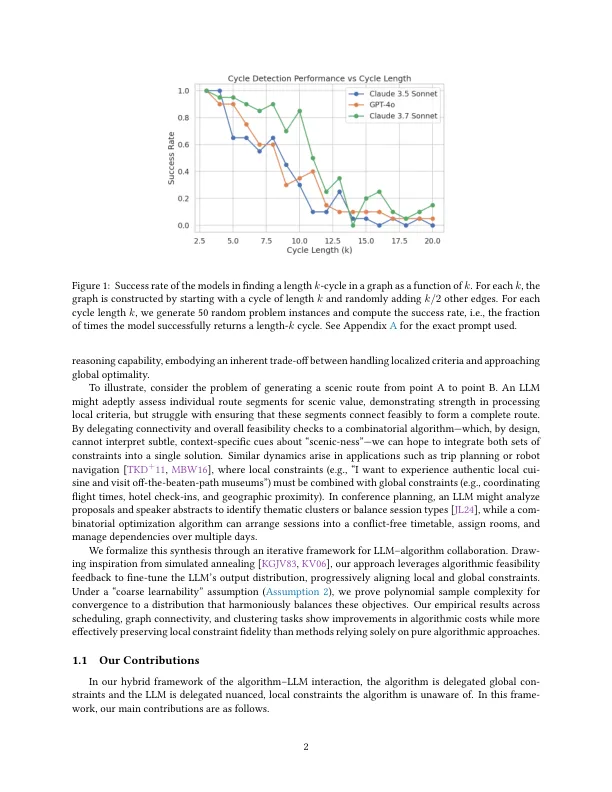

我们提出了一种新颖的方式,将灵活的,与上下文相关的约束集成为组合优化,通过将大型语言模型(LLMS)与传统算法一起使用。尽管LLM擅长解释细微的,当地指定的要求,但他们在执行全球组合可行性方面挣扎。为了弥合此间隙,我们提出了一个迭代的微调框架,其中算法反馈逐渐完善了LLM的输出分布。将其解释为模拟退火,我们引入了一个基于“粗糙可学习性”假设的形式模型,为收敛提供了样本复杂性界限。对调度,图形连接和聚类任务的经验评估表明,与基线采样方法相比,我们的框架平衡了本地表达的约束的灵活性和严格的全局优化。我们的结果突出了混合AI驱动组合推理的有希望的方向。项目代码:https://github.com/pranjal-awasthi/test time-ft

通过LLM驱动的迭代细胞优化 -

主要关键词