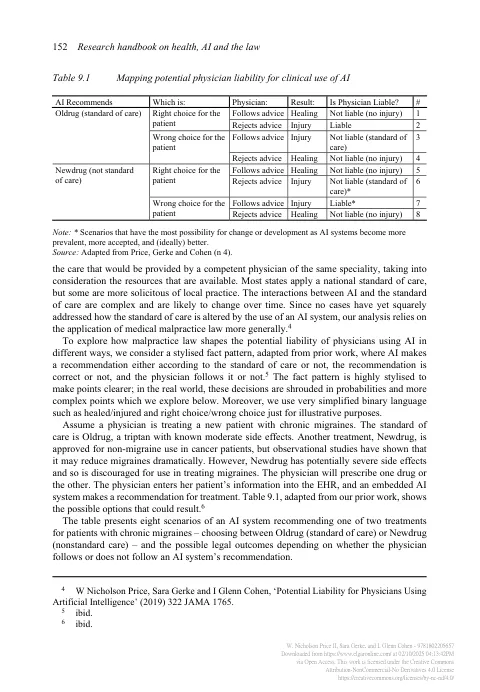

尽管人工智能(AI)具有改善医疗实践的巨大潜力,但肯定会出现错误,有时会导致伤害。谁将承担责任?与AI相关伤害的责任问题不仅引起了潜在责任当事方的直接关注,而且还引起了有关如何开发和采用AI的更广泛的系统性问题。责任景观很复杂,涉及医疗保健提供者和机构以及AI系统的开发商。在本章中,我们考虑了这三个主要责任基因座。一开始,我们注意到一些塑造我们分析的问题。首先,AI的侵权责任领域仍在发展。在撰写本文时,在法院案件中仍未直接解决医疗保健ai liabil的问题,这主要是因为该技术本身是如此新并且仍在实施。因此,我们考虑侵权法的一般原则以及它们最有可能适用的原则。第二,在人工智能侵权背景下,因果关系通常会具有挑战性。在医学背景下,证明受伤的原因常常很难,因为结果通常是概率的,而不是确定性的。添加通常非直觉且有时难以理解的AI模型可能会使因果关系更具挑战性。第三,我们专注于美国的观点。 我们讨论的原则在某种程度上是可以推广的,但最终,有足够的复杂性可以准确地捕获国际差异,这在可用的空间中是不可行的。 系统将使用哪些数据集?第三,我们专注于美国的观点。我们讨论的原则在某种程度上是可以推广的,但最终,有足够的复杂性可以准确地捕获国际差异,这在可用的空间中是不可行的。系统将使用哪些数据集?我们在结论中确实指出了欧洲地平线上一些潜在的实质性变化。第四,从系统的角度来看,个人的医疗保健专业责任虽然复杂,但仅代表了一个较大的拼图,系统设计师必须尝试将其组合在一起以实现全面且最佳设计的责任系统。许多玩家在医疗AI领域进行互动,包括可能承担可能塑造它的责任和监管者的演员。首先,AI开发人员将在基础AI上做出许多关键选择,至少在责任系统中部分指导 - 它会被锁定还是自适应?选择体系结构会使“推翻”系统变得容易或难以使该系统变得容易或难以“否决”?第二,美国食品和药物管理局(FDA)将(有时)确定

在医学中使用人工智能的责任

主要关键词