机构名称:

¥ 1.0

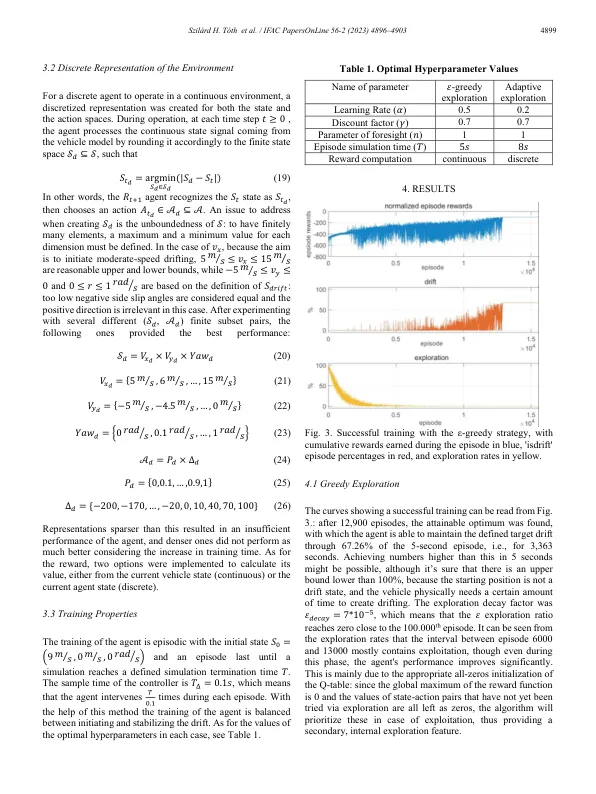

除了上述方法外,在改变环境条件和在线学习的情况下,增强学习(RL)可以具有更大的性能和适应性,这使其成为开发自动驾驶代理的重要方法。对于当前最新应用的状态,深入加固学习(DRL)是迄今为止最受接受和广泛使用的方法(Kiran等,2021)。这背后的主要原因是汽车控制的复杂性质,它需要一种足够精确的近似方法以在连续环境中操作车辆。Cutler&How(2016)的作品,Bhattacharjee等。(2018),Cai等。 (2020)和Orgován等。 (2021)表明,即使在环境中增加了随机元素,基于模型的和模型的DRL都可以解决简单,更复杂的漂移问题。 进一步增强了这些结果,Domberg等。 (2022)引入了一种可以沿任意轨迹漂移的代理,显示了假定的概括能力(2018),Cai等。(2020)和Orgován等。(2021)表明,即使在环境中增加了随机元素,基于模型的和模型的DRL都可以解决简单,更复杂的漂移问题。进一步增强了这些结果,Domberg等。(2022)引入了一种可以沿任意轨迹漂移的代理,显示了假定的概括能力

ScienceDirect

主要关键词