机构名称:

¥ 1.0

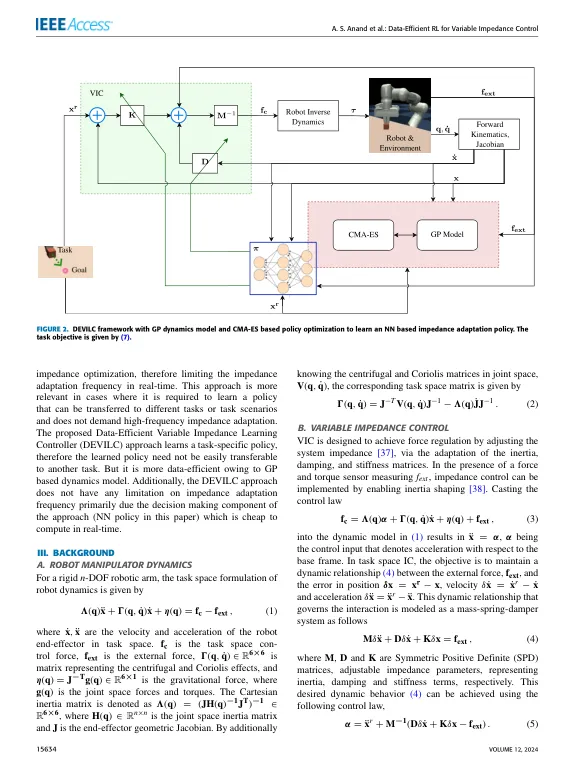

抽象在机器人中实现类似人类的操纵技巧的最关键步骤之一是将合规性纳入机器人控制器中。合规性不仅使机器人的行为安全,而且使其更有效。在这个方向上,可变阻抗控制(VIC)方法为机器人提供了一个框架,以通过采用适应性阻抗法来适应其在执行过程中的合规性。尽管如此,按任务要求的自主调整合规性概况仍然是一个具有挑战性的问题,可以在实践中解决。在这项工作中,我们引入了一种加强学习(RL)的方法,称为DEVILC(数据效率可变阻抗学习控制器),以通过机器人的实际交互来学习可变阻抗控制器。更具体地说,我们使用一种基于模型的RL方法,在每次相互作用之后,机器人迭代地使用高斯过程回归模型学习了其动力学的概率模型。然后,该模型被用来优化调节机器人阻抗的神经网络政策,以使对任务的长期奖励最大化。多亏了基于模型的RL框架,Devilc允许机器人仅通过一些交互学习VIC策略,从而使其对现实世界应用程序实用。在模拟和实验中,我们在Franka Emika Panda机器人操纵器上评估Devilc,以在笛卡尔空间中的不同操纵任务。结果表明,Devilc是通过互动直接在现实世界中自主学习合规技巧的有希望的方向。链接中提供了一个实验的视频:https://youtu.be/_uyr0vye5no。

可变阻抗控制的数据有效增强学习

主要关键词