机构名称:

¥ 1.0

强化学习(RL)范式解决了这些类型的问题,其中代理通过接收观察和潜在的奖励与环境互动,并以其政策指导的行动做出回应。rl框架可以根据其建模假设和模拟环境的可访问性进行分类。基于模型的RL可实现对环境的明确建模,利用专家知识或从经验中学习。博学的世界模型取得了巨大的成功,主要是因为它们创建了简化的状态表示形式,与稀疏和非微分奖励相比产生了更多的训练信号,并促进了学习模型的潜在空间中的互动,绕开了对计算要求和潜在不现实的不现实的专家模拟器的需求。

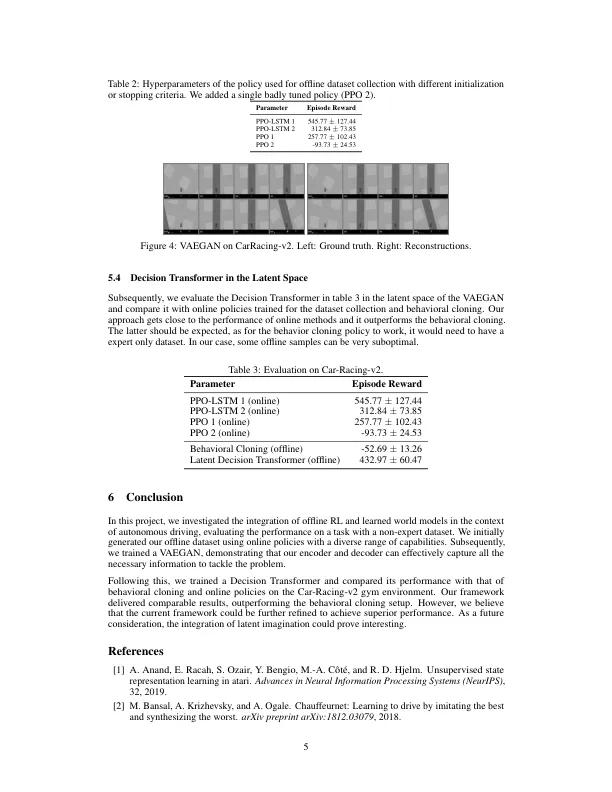

潜在空间中的决策变压器学习离线驾驶政策