机构名称:

¥ 1.0

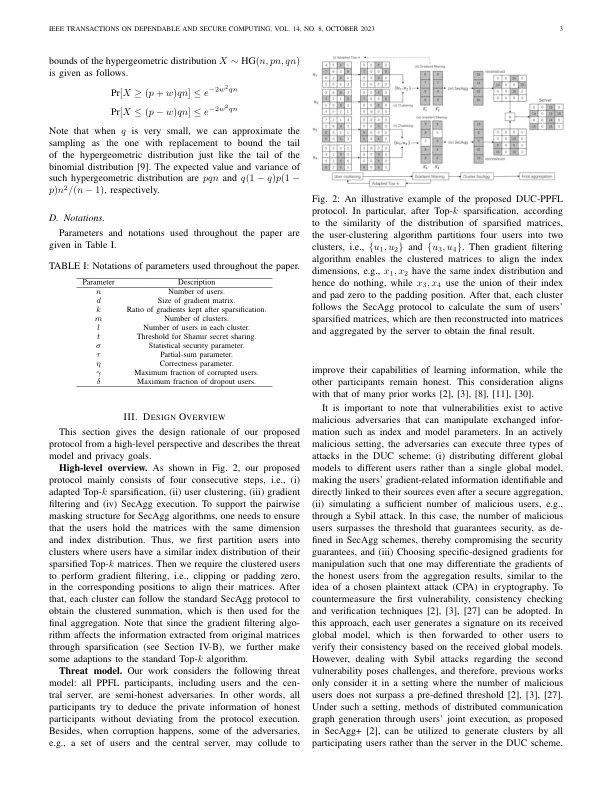

摘要 - 随着机器学习的更广泛采用以及对数据隐私的越来越关注,联邦学习(FL)受到了极大的关注。FL计划通常使一组参与者(即数据所有者)使用其本地数据单独训练机器学习模型,然后将其通过中央服务器的协调来汇总以构建全局FL模型。对标准FL的改进包括(i)通过利用梯度稀疏和(ii)通过采用隐私性汇总(PPAGG)协议来增强聚合的安全性,从而减少梯度传输的通信开销。但是,由于用户稀疏梯度向量的异质性,最新的PPAGG协议并不能轻易与梯度稀疏相互互操作。为了解决此问题,我们提出了一种动态用户聚类(DUC)方法,并采用一组支持协议,根据PPAGG协议和梯度稀疏技术的性质将用户分配到集群中,提供安全性的质量和通信效率。实验结果表明,与基准相比,DUC-FL显着降低了通信开销,并实现了相似的模型精度。所提出的协议的简单性使其对实施和进一步的改进都具有吸引力。

动态用户聚类,以提供高效和隐私权...

主要关键词