机构名称:

¥ 1.0

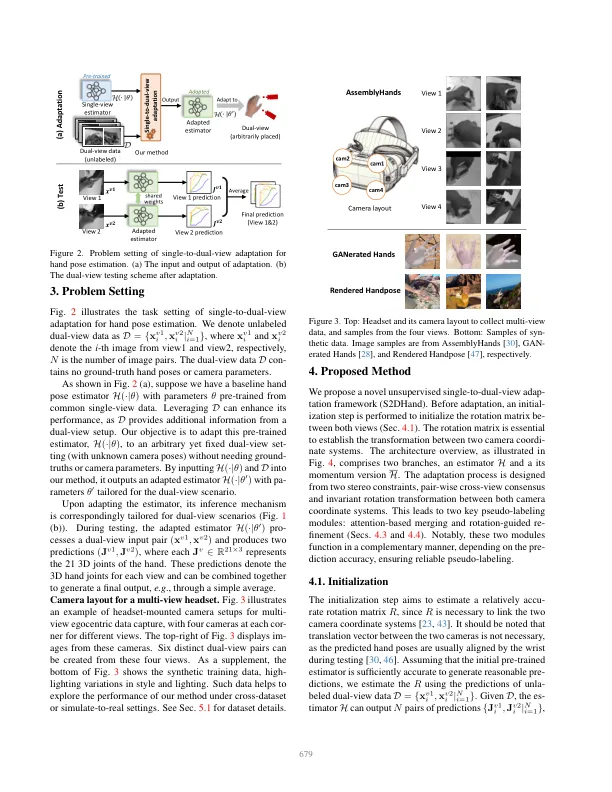

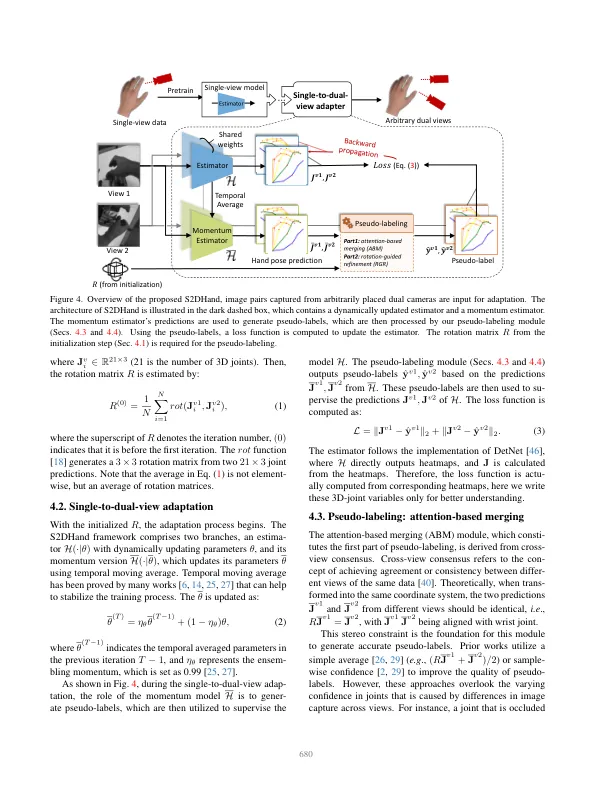

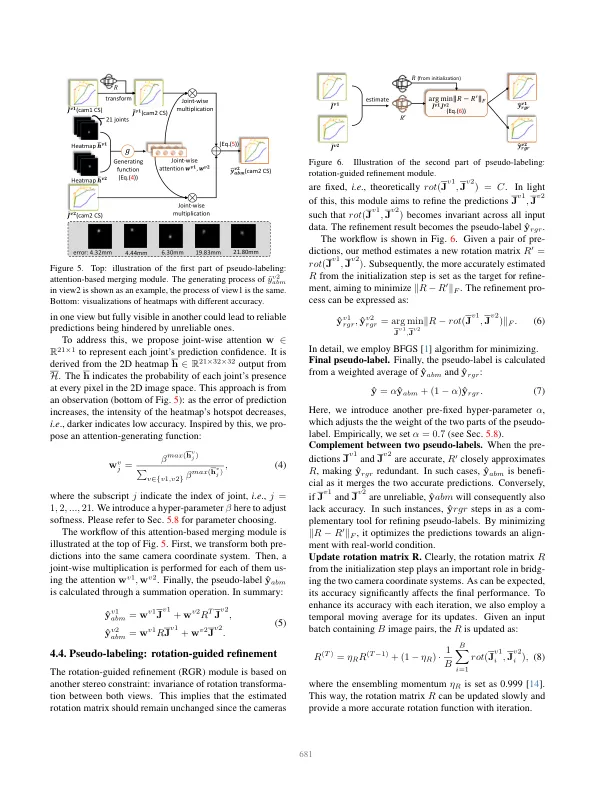

对准确的3D手姿势估计的追求是理解以自我为中心视力领域的人类活动的基石。大多数现有估计方法仍然依赖单视图像作为输入,从而导致潜在的局限性,例如,深度有限的视野和义务。解决这些问题,添加另一个相机以更好地捕获手的形状是实践方向。然而,现有的多视图手姿势姿势方法具有两个主要缺点:1)重新训练的多视图注释,这些注释是备用的。2)在测试过程中,如果相机参数/布局与训练中使用的相同,则模型将变为inpapplicable。在本文中,我们提出了一种新颖的单算观看改编(S2DHAND)解决方案,该解决方案将预先训练的单视估计器适应双视图。与现有的多视图训练方法相比,1)我们的适应过程是无监督的,消除了对多视图注释的需求。2)此外,我们的方法可以处理带有未知相机参数的Arbitarary双视图对,从而使该模型适用于不同的相机设置。具体来说,S2DHAND建立在某些立体声约束上,包括两种视图之间的成对跨视图共识和转换的不变性。这两个立体声约束以互补的方式使用来进行伪标记,从而允许可靠的适应性。评估结果表明,在内部和跨数据库设置下,S2DHAND在任意摄像机对上实现了重大的实现,并且胜过具有领先性能的现有适应方法。项目页面:https://github.com/ut-vision/s2dhand。

egecentric 3D手姿势估计的单一对偶视图改编

主要关键词