机构名称:

¥ 1.0

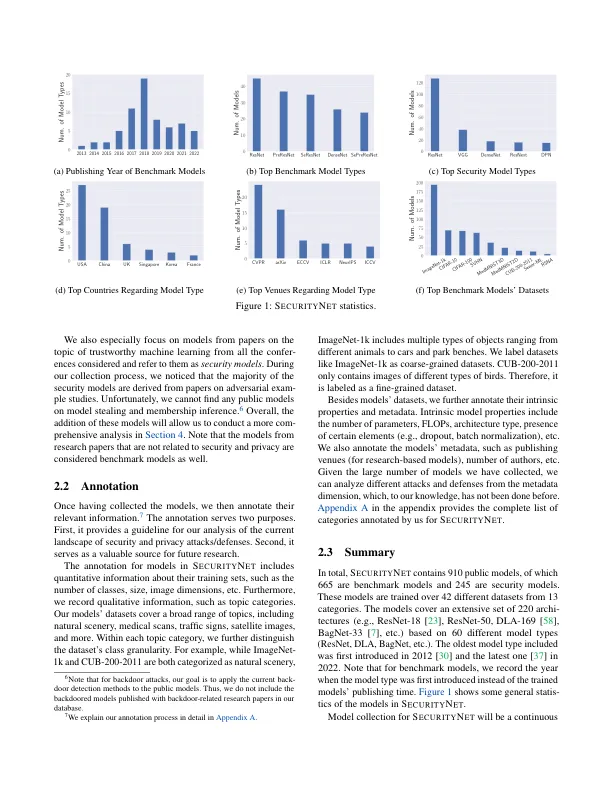

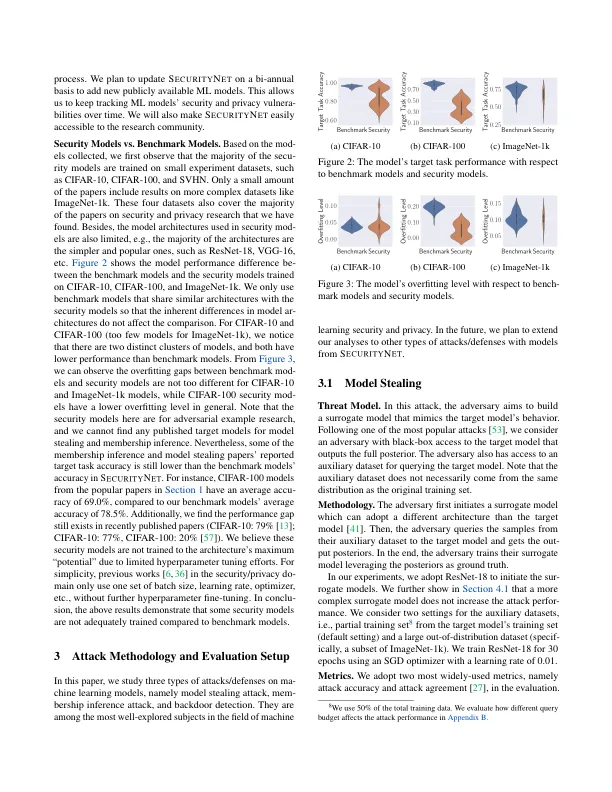

虽然高级机器学习(ML)模型在许多现实世界应用中都构建了,但以前的工作表明这些模型具有安全性和隐私性漏洞。在该领域已经进行了各种经验研究。但是,大多数实验都是对安全研究人员本身训练的目标ML模型进行的。由于对具有复杂体系结构的高级模型的高度计算资源需求,研究人员通常选择使用相对简单的架构在典型的实验数据集中培训一些目标模型。我们争辩说,要全面了解ML模型的漏洞,应对具有各种目的训练的大型模型进行实验(不仅是评估ML攻击和防御的目的)。为此,我们建议使用具有Inter-Net(公共模型)权重的公开模型来评估ML模型上的攻击和防御。我们建立了一个数据库,即具有910个注释的图像分类模型的数据库。然后,我们分析了几种代表性的AT-TACS/防御能力的有效性,包括模型窃取攻击,会员推理攻击以及对这些公共模型的后门检测。我们的评估从经验上表明,与自训练的模型相比,这些攻击/防御措施的性能在公共模型上可能有很大差异。我们与研究社区1分享了SCURITY N ET,并倡导研究人员在公共模型上进行实验,以更好地证明其未来所提出的方法的有效性。

s ecurity n et:评估公共模型上的机器学习漏洞

主要关键词