机构名称:

¥ 1.0

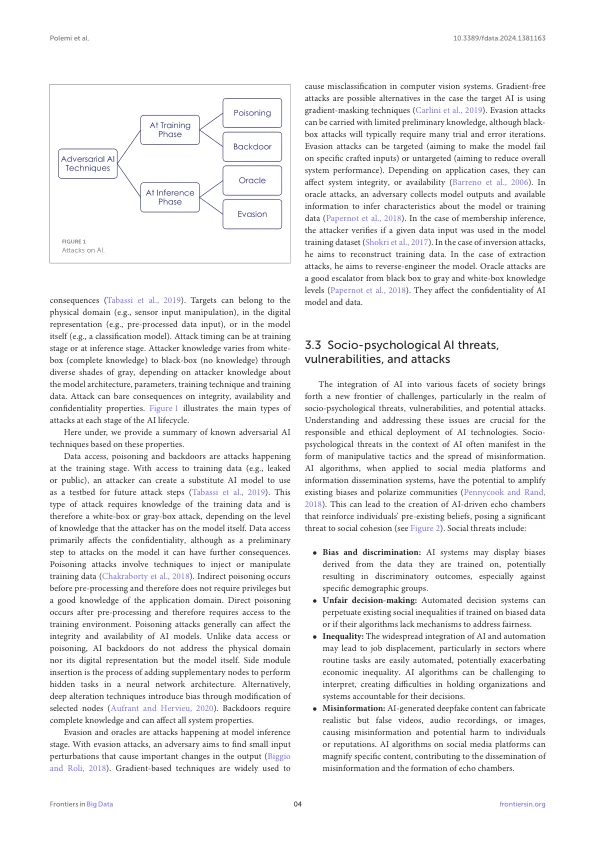

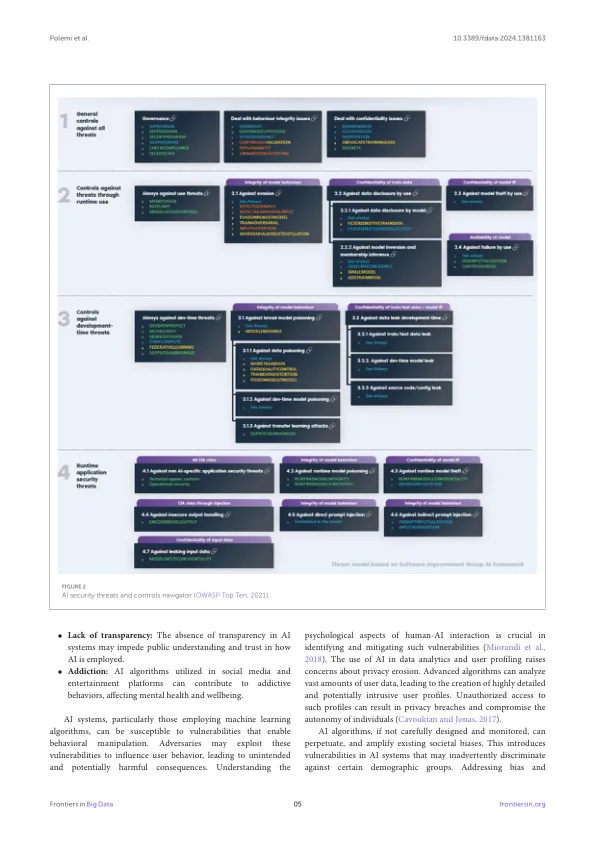

本文解决了现有的AI风险管理框架中的关键差距,强调了对人为因素的忽视以及缺乏社会相关或人类威胁的指标。从NIST AI RFM和Enisa提供的见解中得出,研究强调了了解人类相互作用的局限性以及道德和社会测量的局限性。本文探讨了可信赖性的各个方面,涵盖了立法,AI网络威胁情报和AI对手的特征。它深入研究了技术威胁和漏洞,包括数据获取,中毒和后门,强调了网络安全工程师,AI专家和社会心理学行为 - 行为 - 行为 - 伦理学专业人员之间协作的重要性。此外,研究了与AI融入社会相关的社会心理威胁,解决了诸如偏见,错误信息和隐私侵蚀等问题。手稿提出了一种全面的AI可信度方法,结合了技术和社会缓解措施,标准和正在进行的研究计划。此外,它还引入了创新的防御策略,例如网络社会练习,数字克隆和对话代理,以增强对对手的理解并加强AI安全性。本文以跨学科合作,宣传运动和持续研究的呼吁结束,以创建一个与道德标准和社会期望相符的强大而有弹性的AI生态系统。

在管理AI可信度风险方面挑战和努力

主要关键词