机构名称:

¥ 1.0

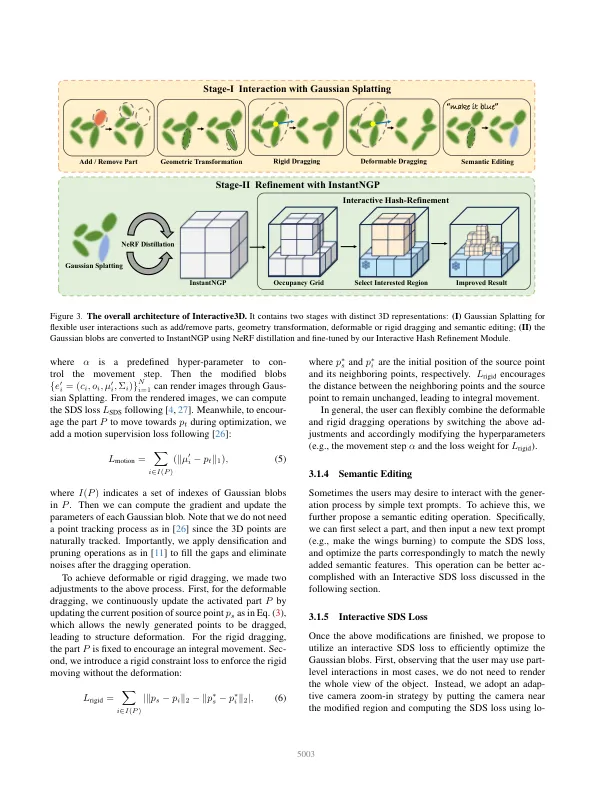

最近进步[20,29,30]中的2D图像结构,以方法为例,例如在广泛的文本图像配对数据集中受过训练的扩散模型(例如,Laion-series [31]),在与文本提示符的一致性图像中取得了显着的前进。尽管取得了成功,但实现对图像产生的精确控制以满足复杂的用户期望仍然是严重的挑战。ControlNET [38]通过在特定条件数据集上进行微调修改Foun-odation-2D扩散模型来解决此问题,从而提供由用户特异性输入引导的微妙控制机制。另一方面,尽管有希望的进展[27,35],但与2D图像生成中遇到的那些相比,3D对象的生成更为复杂。al-尽管从透视感中观察到了进步,包括直接3D数据集[10,25]上的3D扩散模型,以及将2D扩散率提升到3D复位(例如NERF [21])通过SDS损失的技术优化[27],没有完全对生成Ob-Ob-ob-ob-ob-jects的控制。对初始文本提示或2D参考图像的依赖严重限制了发电的可控性,并且通常会导致质量较低。文本提示缺乏准确传达复杂3D设计的特异性;尽管2D参考图像可以告知3D重建,但它们并没有捕获3D结构的完整深度,可能导致各种意外的人类。此外,基于2D图像的个性化缺乏直接3D操纵可以提供的灵活性。这些障碍表明需要采取不同的策略。实现可控制的3D发电的直接想法是将控制网络调整为3D生成。但是,该策略遇到了重大障碍:(i)3D的控制信号本质上更为复杂,这使得与2D范式相比,有条件的3D数据集对构成的3D数据集进行了挑战; (ii)3D域中没有强大的基础模型,例如2D [20]的稳定扩散,阻碍了此时开发微调技术的可能性。结果,我们倾向于

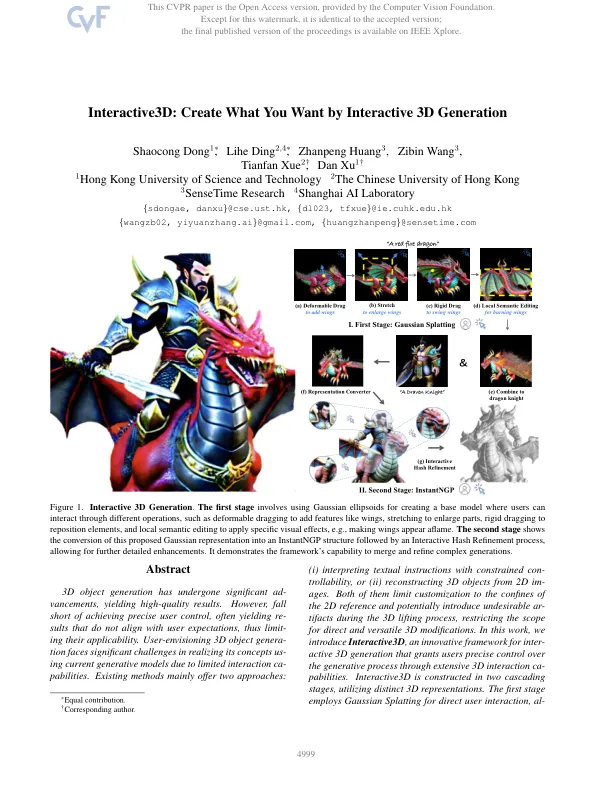

通过交互式3D代创建想要的东西

主要关键词