机构名称:

¥ 1.0

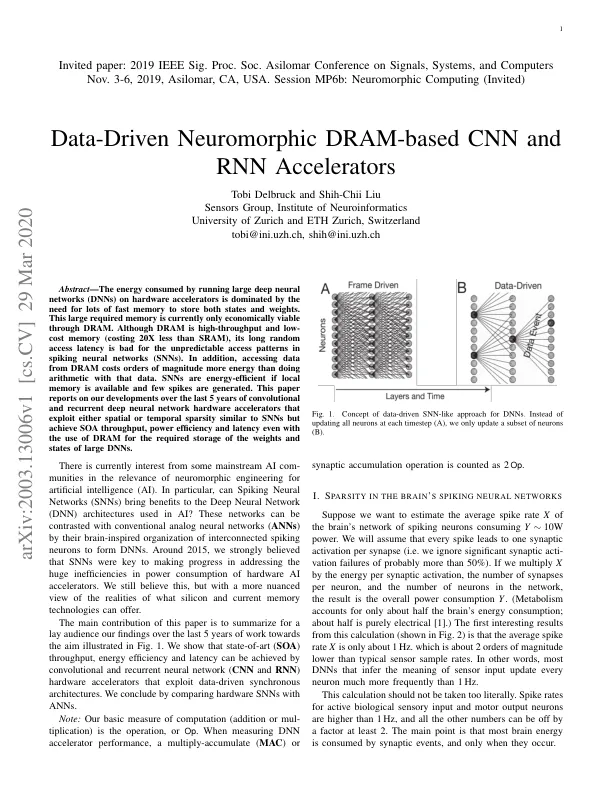

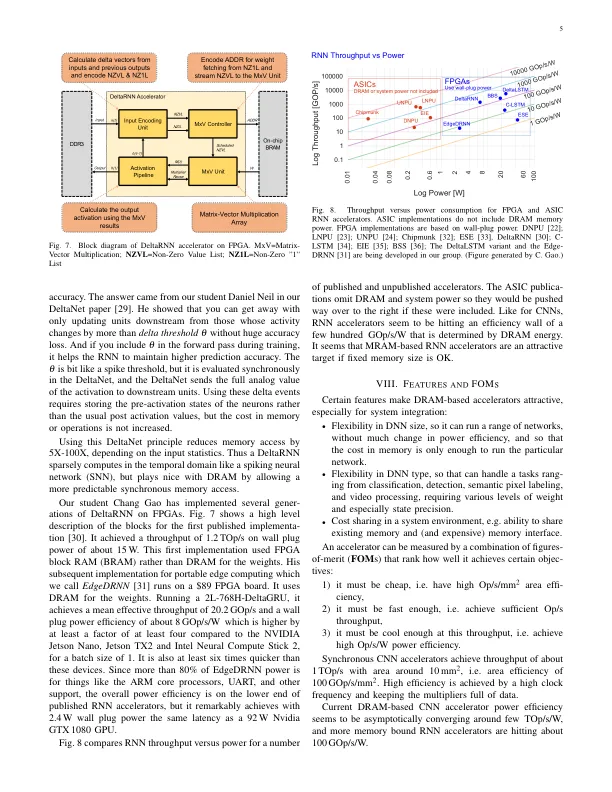

摘要 — 在硬件加速器上运行大型深度神经网络 (DNN) 所消耗的能量主要来自需要大量快速内存来存储状态和权重。目前,只有通过 DRAM 才能经济地满足这种大型内存需求。尽管 DRAM 是高吞吐量和低成本内存(成本比 SRAM 低 20 倍),但其较长的随机访问延迟不利于脉冲神经网络 (SNN) 中不可预测的访问模式。此外,从 DRAM 访问数据比使用该数据进行算术运算消耗的能量高出几个数量级。如果有本地内存可用且产生的峰值很少,则 SNN 是节能的。本文报告了我们在过去 5 年中在卷积和循环深度神经网络硬件加速器方面的发展,这些加速器利用了与 SNN 类似的空间或时间稀疏性,但即使使用 DRAM 来存储大型 DNN 的权重和状态,也能实现 SOA 吞吐量、功率效率和延迟。

基于数据驱动的神经形态 DRAM 的 CNN 和 RNN 加速器