机构名称:

¥ 1.0

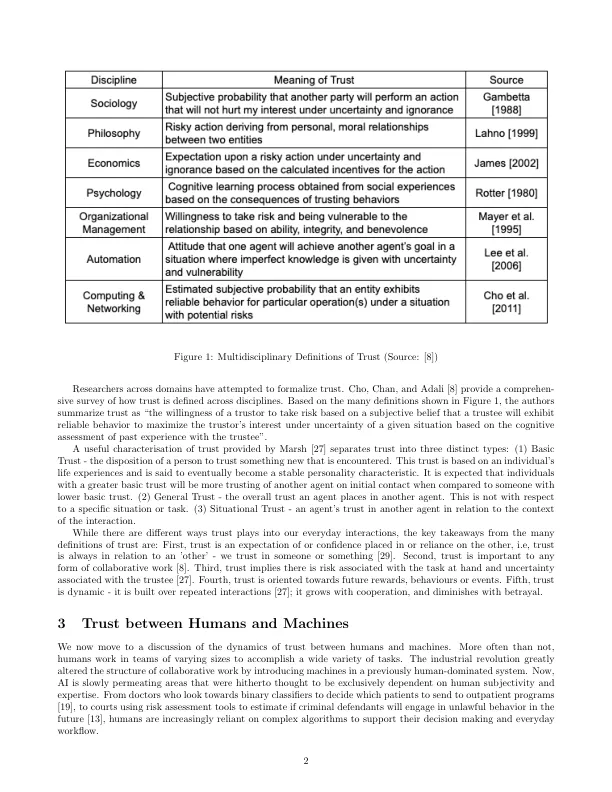

不可否认,人工智能系统在我们日常生活中无处不在:我们与人工智能助手交谈,我们让算法驾驶我们的汽车,我们寻求他们的建议来决定购买什么,等等。虽然我们在构建相当准确和高效的人工智能系统方面在各个领域取得了重大进展,但在大多数情况下,仍然需要人类的监督和/或干预。人类和人工智能之间需要合作的原因有很多。一方面是他们能力的互补性。虽然人工智能可以查看大量数据并做出数学上精确的推断,但它仍然缺乏人类理解抽象概念和用更少的数据进行概括的能力。另一方面,一个关键的考虑因素是,算法并非万无一失,这需要这种人类监督,特别是在高风险决策中。已经有一些案例表明,由于训练数据有限或有偏差,算法推荐存在偏差。人们还报告了由于技术故障导致算法推荐错误的情况 [2]。为了有效利用互补能力并有效减少算法错误,我们需要设计出人类用户能够充分理解并适当信任的系统。为此,研究人员强调了提高模型可解释性和可解释性的重要性。这些努力的重点是以一种有助于人类理解模型的方式传达模型的工作和最终建议。然而,Lakkaraju 和 Bastani [21] 以及 Bansal 等人 [3] 最近的研究表明,用更多信息或解释补充算法决策并不一定能帮助人类用户做出更好的决策。这种观察的一个可能解释是,人类无法建立与算法能力相适应的信任。正如 Huang 和 Fox [17] 所说,现实世界中的决策是基于理性计算(在可用信息和心理资源的限制范围内)和信任的混合。虽然可解释性努力力求使模型更易于理解,但它们并没有积极考虑人类对模型的依赖或信任。在这篇评论中,我们强调了在设计人机有效协作时需要考虑人类信任的问题。在这篇文章中,我们回顾了人机交互方面的工作,重点是了解人类如何以及何时信任机器。1

人类与人工智能之间的信任:简要回顾

主要关键词