机构名称:

¥ 1.0

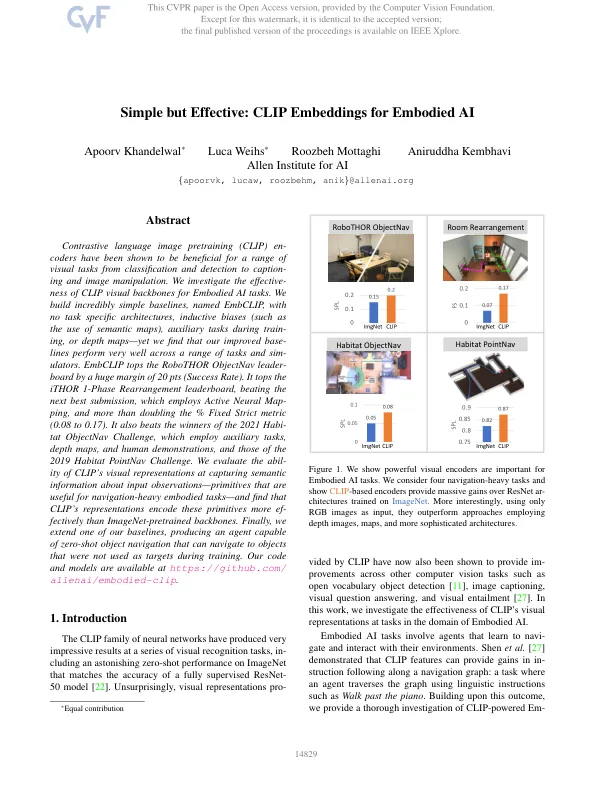

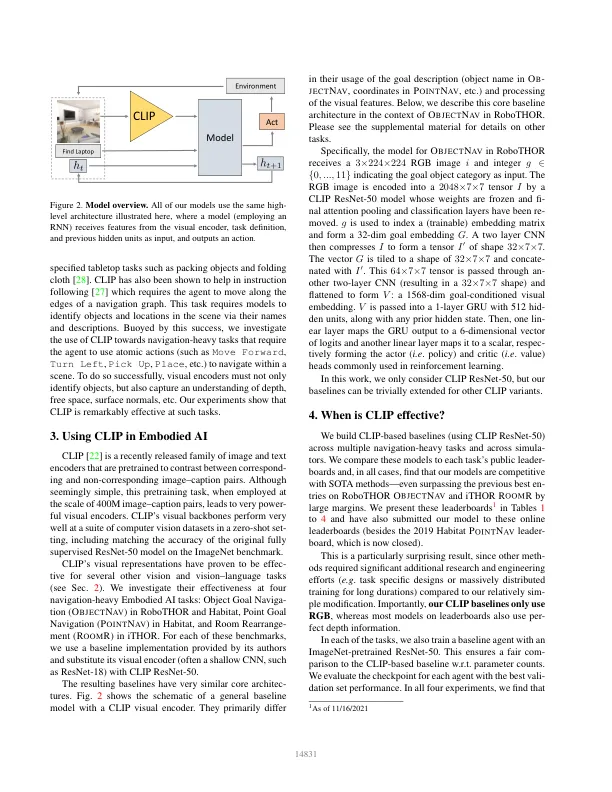

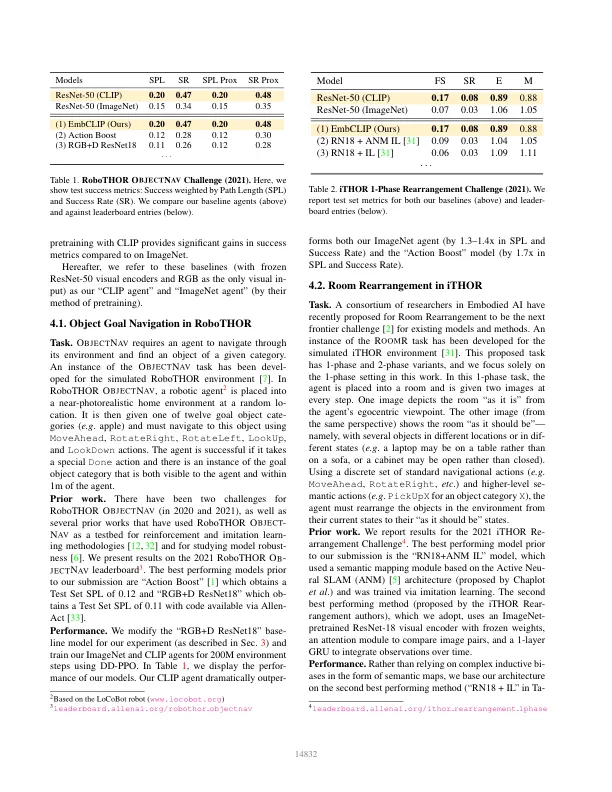

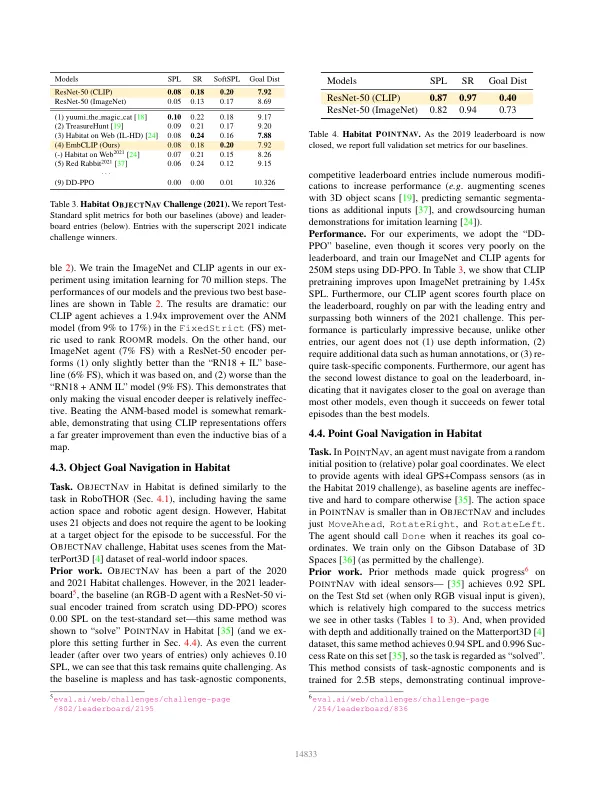

对比语言图像预训练 (CLIP) 编码器已被证明对从分类和检测到字幕和图像处理等一系列视觉任务有益。我们研究了 CLIP 视觉主干对 Embodied AI 任务的有效性。我们构建了非常简单的基线,称为 EmbCLIP,没有任务特定的架构、归纳偏差(例如使用语义图)、训练期间的辅助任务或深度图——但我们发现我们改进的基线在一系列任务和模拟器中表现非常出色。EmbCLIP 在 RoboTHOR ObjectNav 排行榜上以 20 分(成功率)的巨大优势名列前茅。它在 iTHOR 1-Phase Rearrangement 排行榜上名列前茅,击败了采用主动神经映射的第二佳提交作品,并且 % Fixed Strict 指标增加了一倍多(0.08 到 0.17)。它还击败了 2021 年 Habitat ObjectNav 挑战赛的获胜者,该挑战赛采用了辅助任务、深度图和人工演示,以及 2019 年 Habitat PointNav 挑战赛的获胜者。我们评估了 CLIP 的视觉表示在捕获输入观察的语义信息方面的能力——这些原语对于导航繁重的具身任务很有用——并发现 CLIP 的表示比 ImageNet 预训练的主干更有效地编码了这些原语。最后,我们扩展了我们的一个基线,生成了一个能够进行零样本物体导航的代理,它可以导航到训练期间未用作目标的物体。我们的代码和模型可以在 https://github.com/allenai/embodied-clip 获得。

简单但有效:具身人工智能的 CLIP 嵌入

主要关键词