机构名称:

¥ 2.0

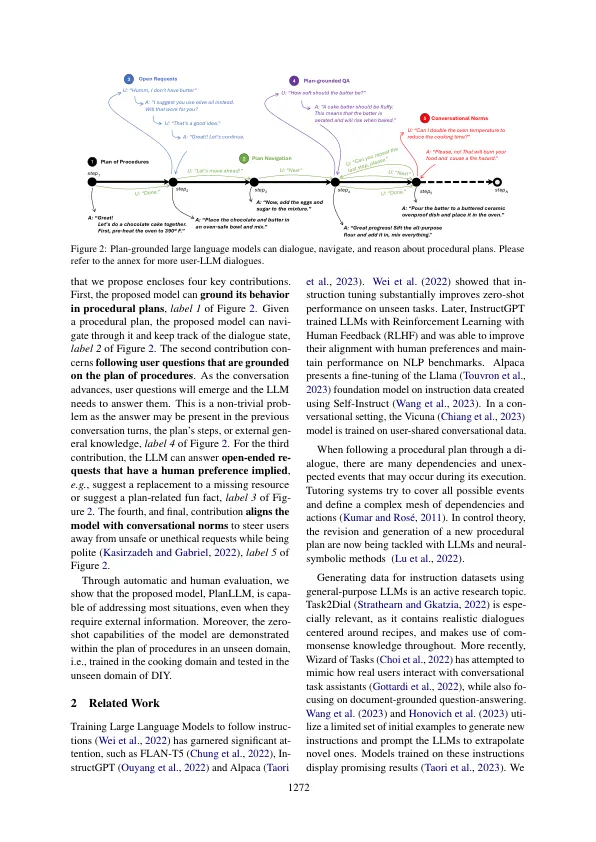

训练大型语言模型(LLM)遵循用户说明,已显示出具有足够能力在与人类对齐时能够流利的能力的LLM。然而,尚不完全清楚LLM如何在混合主动性设置中引导计划的对话,其中指令以对话的两个方向流动,即LLM和用户都提供指令。在本文中,我们解决了双重目标混合定位对话环境,其中LLM不仅在任意计划上以对话为基础,而且还试图满足程序计划和用户说明。LLM然后负责指导用户完成计划,同时适应新情况,回答问题并在需要时激活安全护栏。我们提出了一个新颖的LLM,该LLM以程序计划为基础,可以采取Di-Alogue倡议,并对系统的行为执行护栏,同时也改善了LLM对意外用户行为的响应。在受控设置中进行的实验,并且使用真实用户表明,我们称之为Planllm的表现最佳模型在强大的基准上实现了2.1倍的进步。此外,实验还显示出对看不见的域的良好概括。1

双重目标对话设置的计划接近的大语言模型