机构名称:

¥ 7.0

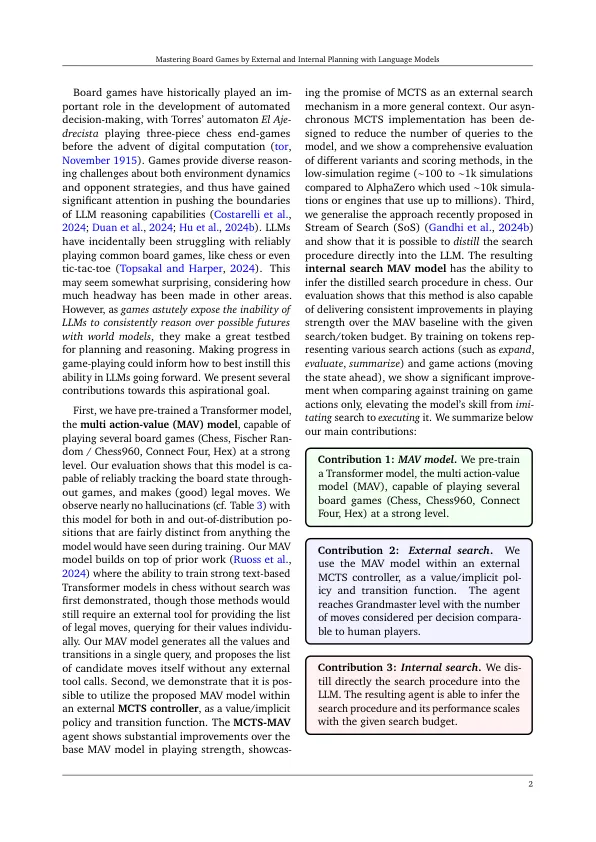

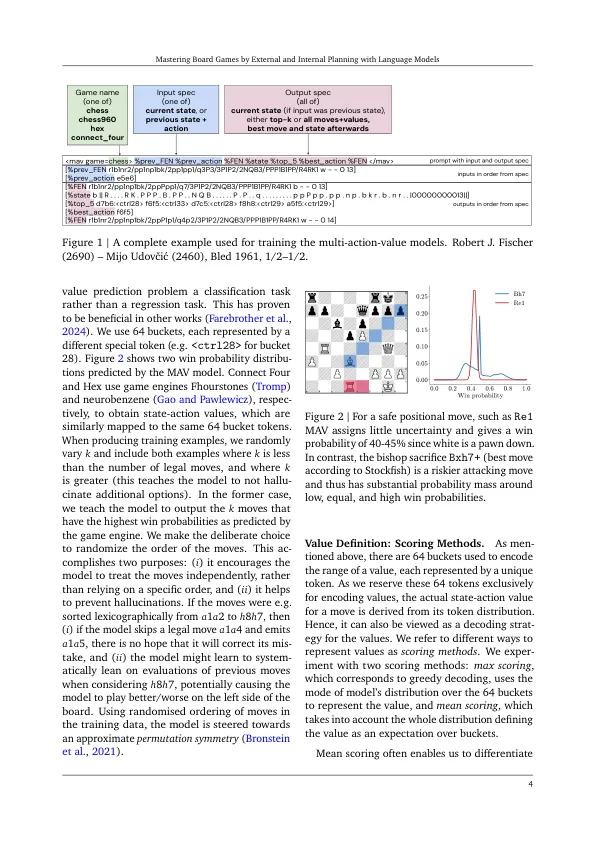

虽然大型语言模型在一系列复杂的任务(例如文本生成,问答,摘要)上表现良好,但强大的多步计划和推理仍然对他们来说是一个巨大的挑战。在本文中,我们表明,基于搜索的计划可以显着提高LLM在多个棋盘游戏中的表现力量(国际棋盘,Fischer Random / Chess960,Connect Four和Hex)。我们介绍,比较和对比两种主要方法:在外部搜索中,该模型指导蒙特卡洛树搜索(MCTS)的推出和评估,而无需呼叫外部引擎,并且在内部搜索中,该模型直接生成了潜在的潜在期货的线性化树,并产生了最终选择。两者都建立在相关领域知识上预先训练的语言模型上,从而捕获这些游戏中的过渡和价值功能。我们发现,我们的预训练方法可以最大程度地减少幻觉,因为我们的模型在国家预测和法律行动方面非常准确。此外,内部和外部搜索确实改善了针对最先进的机器人的胜利率,甚至在国际象棋中达到了大师级的表现,同时按类似的举动计数搜索预算与人类大师的搜索预算相似。我们将搜索与域知识相结合的方式并非特定于棋盘游戏,这表明将直接扩展为更通用的语言模型推论和培训技术。

通过语言模型通过外部和内部计划掌握棋盘游戏

主要关键词