机构名称:

¥ 1.0

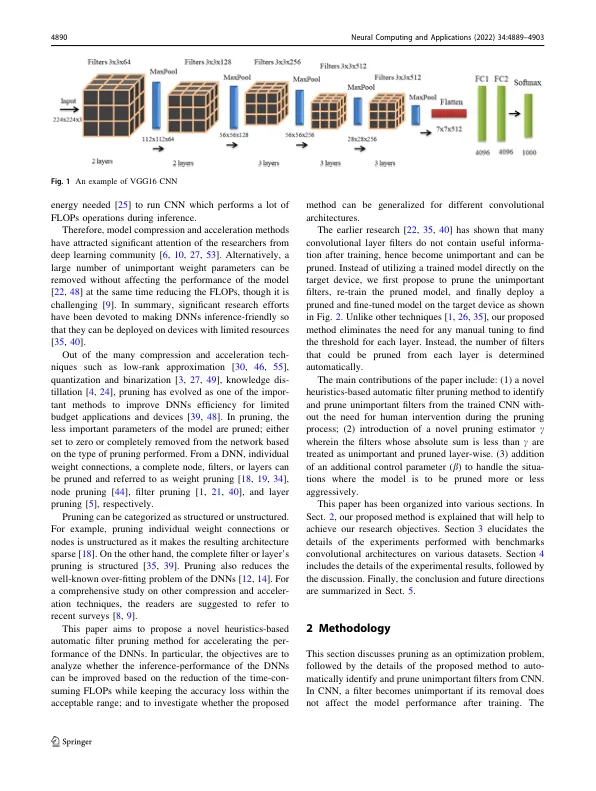

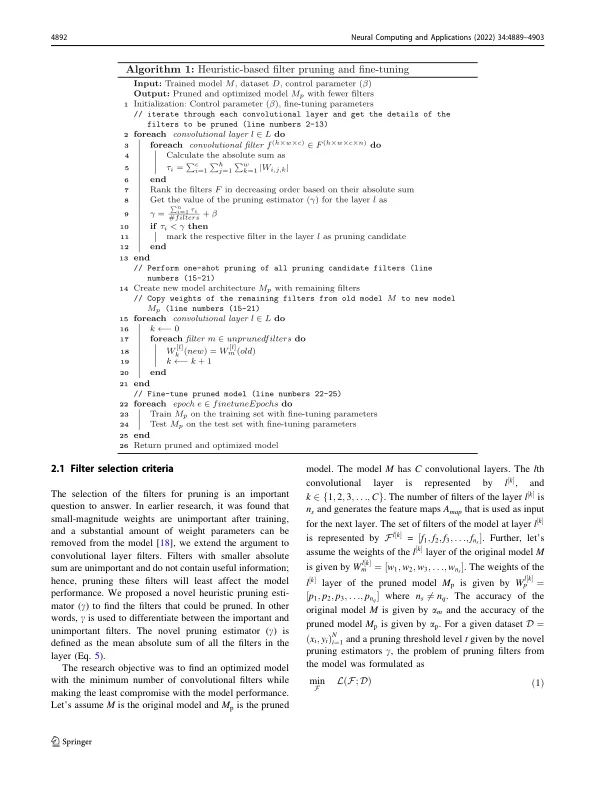

摘要 深度神经网络 (deep NN) 的性能取决于大量需要训练的权重参数,这是一个计算瓶颈。更深层次的架构日益增长的趋势对资源受限设备上的训练和推理方案造成了限制。剪枝是去除深度 NN 中不重要的参数并使其更容易在资源受限的设备上部署以供实际应用的重要方法。在本文中,我们提出了一种基于启发式的新型滤波器剪枝方法来自动识别和剪枝不重要的滤波器,并加快资源有限设备上的推理过程。不重要的滤波器的选择由一种新颖的剪枝估计器 (c) 进行。所提出的方法在各种卷积架构 AlexNet、VGG16、ResNet34 和数据集 CIFAR10、CIFAR100 和 ImageNet 上进行了测试。在大规模 ImageNet 数据集上的实验结果表明,VGG16 的 FLOP 可降低高达 77.47%,实现 5 倍推理加速。与其他最先进方法相比,更流行的 ResNet34 模型的 FLOP 降低了 41.94%,同时保持了具有竞争力的性能。

基于启发式的深度神经网络自动修剪

主要关键词