机构名称:

¥ 2.0

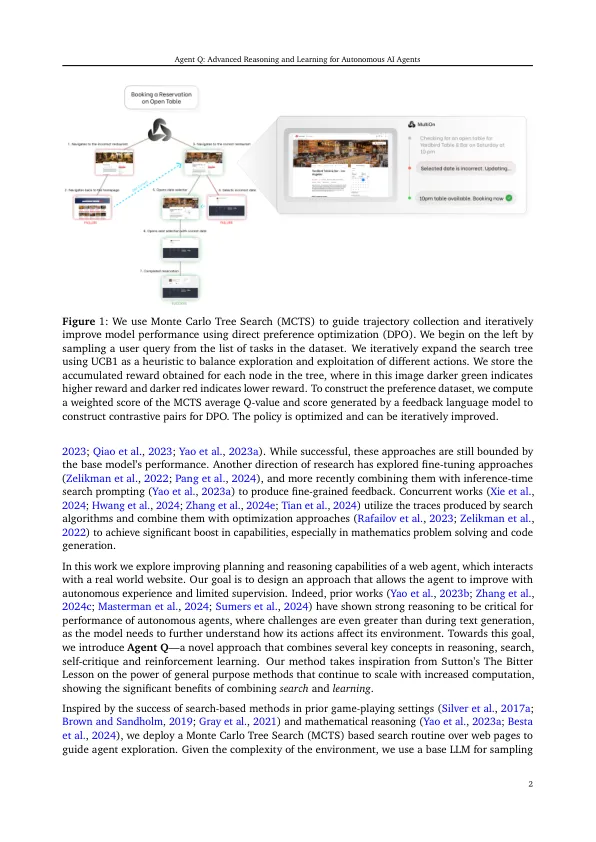

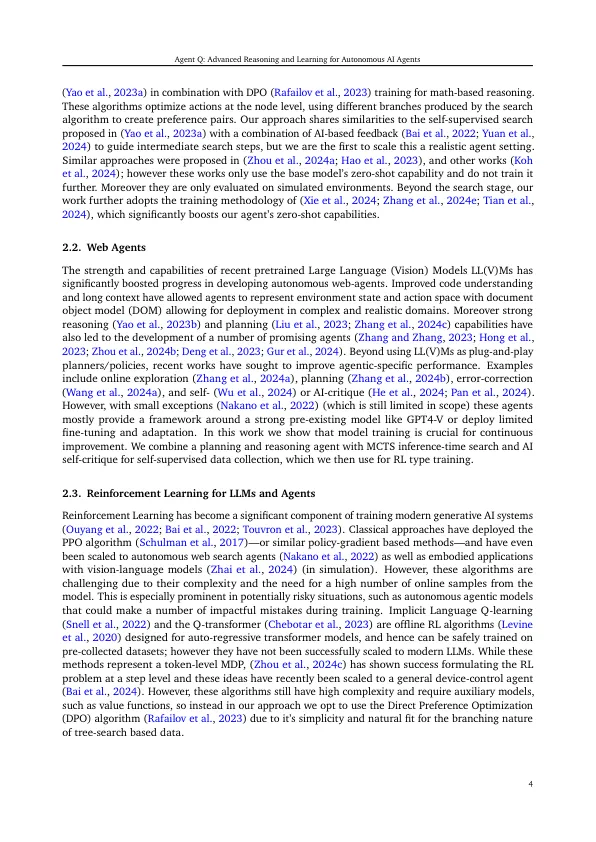

大语言模型(LLM)在需要复杂推理的自然语言任务中表现出了显着的功能,但是它们在交互式环境中的代理,多步骤推理中的应用仍然是一个艰难的挑战。静态数据集上的传统监督预训练在实现在Web Navigation(例如Web Navigation)中执行复杂决策所需的自主代理能力时跌落。先前试图通过对精选的专家演示进行微调的微调来弥合这一差距 - 通常会遭受更复杂的错误和有限的勘探数据,从而导致了次优政策的结果。为了克服这些挑战,我们提出了一个框架,将带有指导的蒙特卡洛树搜索(MCTS)搜索与自我批评机制和使用直接优先优化(DPO)算法的非政策变体对代理相互作用进行迭代微调。我们的方法使LLM代理可以从成功和失败的轨迹中有效学习,从而改善其在复杂的多步推理任务中的概括。我们在网络商店环境(一个模拟的电子商务平台)中验证了我们的方法,在该平台上,它始终超过行为的克隆和加强基线,并在配备了进行在线搜索的能力时击败平均人类绩效。在实际预订方案中,我们的方法论将Llama-3 70B型号的零拍摄性能从18.6%升至81.7%的成功率(相对增长340%),经过一天的数据收集,并在线搜索中进一步增加到95.4%。我们认为,这代表了自主代理人能力的实质性飞跃,为在现实世界中更复杂和可靠的决策铺平了道路。

代理问:自主AI代理的高级推理和学习

主要关键词