机构名称:

¥ 1.0

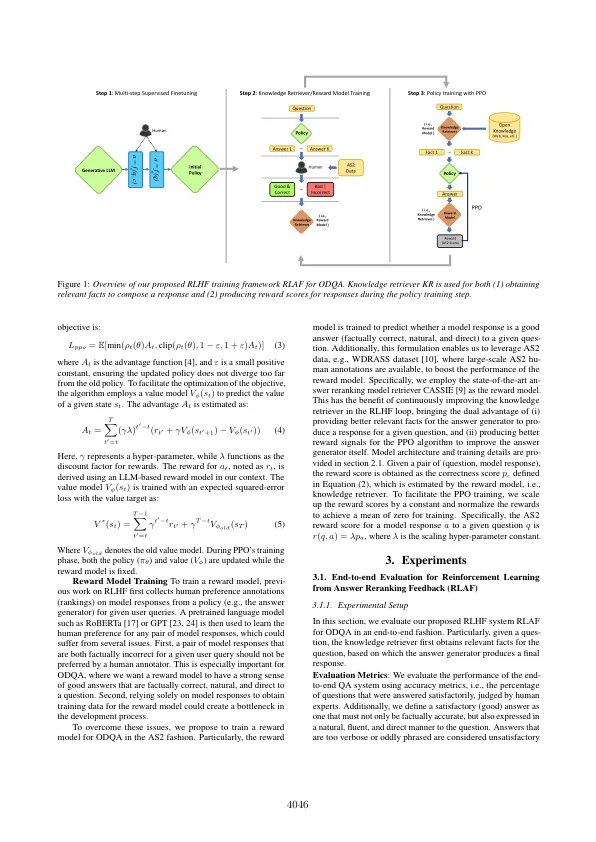

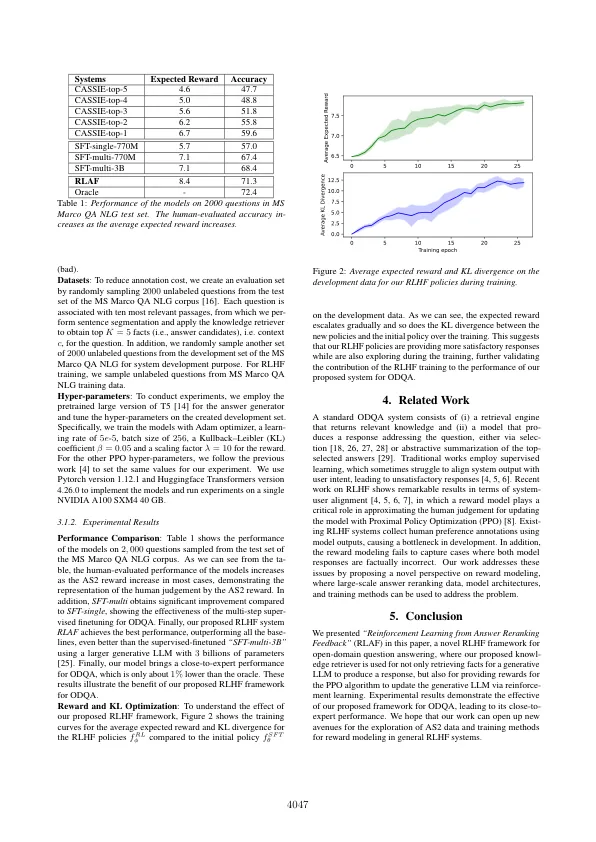

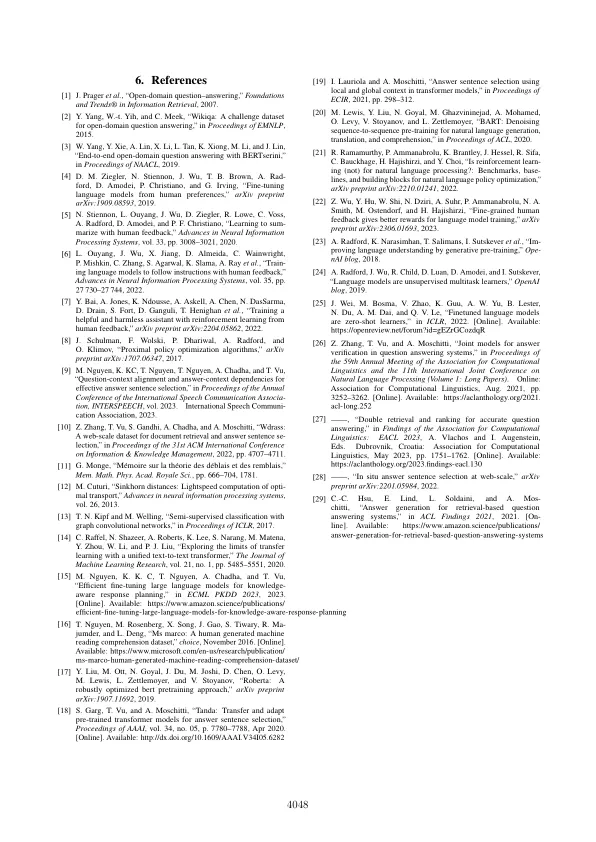

检索增强的生成(RAG)是一种证明大语言模型(LLMS)的准确性和可靠性的方法,以进行开放域问答(ODQA)。传统的AP-PARACHES依赖于监督学习,这可能导致误导用户意图和系统输出。从人类反馈中学习(RLHF)通过使用人类偏好反馈训练奖励模型来解决此问题。在这项工作中,我们介绍了一个新颖的RLHF框架,用于ODQA,利用现有的大规模答案重新计算数据集用于培训重新模型。特别是,我们对ODQA的奖励模型扮演两个互补的角色:(i)将排名分数作为PPO的重新分配,以及(ii)检索相关事实,使ODQA系统能够提出事实答案。实验性媒介表明我们提出的框架对RLHF有效,从而导致ODQA的近乎专家性能。索引术语:检索效果的一代,加强学习,人类反馈,回答reranking

从答案中学习的加固学习