机构名称:

¥ 1.0

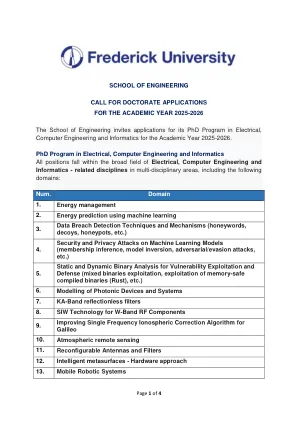

2。模型安全理论和实践保证对AI/ML系统的安全性和鲁棒性需要深入了解模型结构,例如神经网络层,激活功能等以及该结构对模型行为的影响。结构的选择 - 通常是为了追求最佳性能而选择的 - 从攻击易感性到数据暴露风险,可能会具有一系列安全含义。2.1表征,评估和保证我们可以针对潜在的安全问题测试模型结构,并且我们可以以保存(非侵入性)方式进行隐私吗?我们将研究某些组成部分和设计模式的存在(或不存在)是否表示攻击的脆弱性;以及此类分析是否可用于AI/ML模型安全保证。2.2训练进化,深度学习理论的最新突破使人们对复杂模型行为,从第一次初始化和整个优化过程中进行了一些了解。我们的问题是这些工具,例如模型函数近似器神经切线内核(NTK)可用于在训练动力学期间对安全性发表声明。例如,梯度流中是否存在更高或更低的安全性区域?我们可以检测到它们,甚至可以针对高安全性的区域吗?2.3模型反转这是从训练有素的模型函数的预图像中获取表示或样本的能力。我们可以在数学上说什么(大约)解决AI/ML的反问题?2.5稳定性和可信度是模型稳定性是一种良好的信任度量吗?我们可以保证反转稳健性,以及哪些结构性特征可以允许这种保证?2.4灵敏度和攻击检测的几何形状可以使用几何工具(特别是热带几何形状)来表征模型对新数据点的敏感性以及存在邪恶数据的存在,例如有毒样本或对抗性示例?不稳定的模型更容易受到对手的影响?例如,可以定义一个稳定性语句,例如Lipschitz(使用距离距离的度量标准,例如Gromov-Hausdorff),可以用来对安全声明?2.6效率的安全性含义是使非常大的模型可进行,我们经常转向降低复杂性的方法,例如稀疏,替代模型,修剪,定量等。这通常会降低任务性能,

国防与安全盛大挑战:AI安全 - 要求...

主要关键词