机构名称:

¥ 1.0

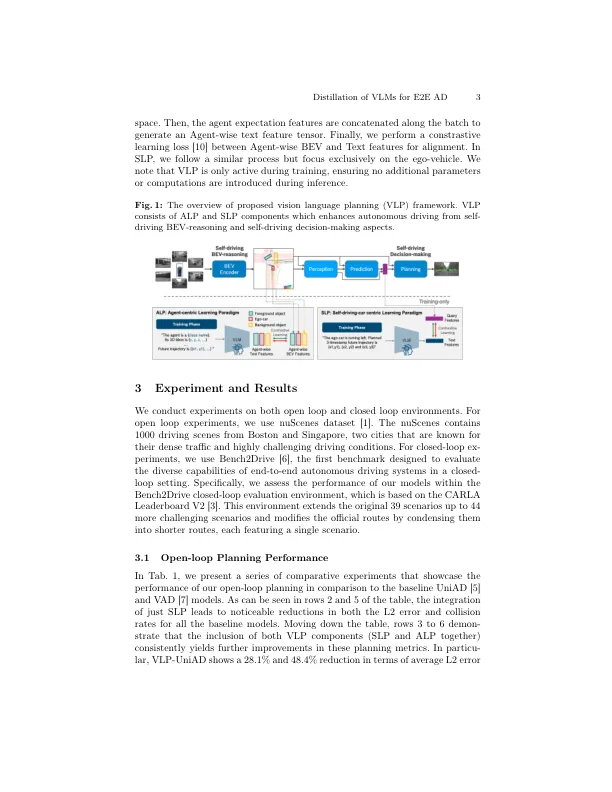

摘要。近年来,已经在自动驾驶中调查了大型视力和语言模型(VLM),以解决长期存在的问题,包括推理,概括和长尾方案。但是,将VLM的有效整合到自主驾驶框架中仍然是一个悬而未决的问题。在本文中,我们提出了VLP,这是一个新颖的视觉语言规划框架,它利用了大型视觉语言模式来弥合语言理解与自动驾驶之间的差距。VLP是一种训练方法,它通过提出对比度学习目标来提炼VLM的力量到端到端模块化自主驾驶。在开路和闭环任务上进行了广泛的实验,验证了VLP的实用性。尤其是,VLP通过与先前的最佳方法相比,分别在平均L2错误和碰撞率方面,在Nuscenes数据集上实现了状态的端到端计划绩效。

蒸馏视觉语言模型,以增强结局...

主要关键词