机构名称:

¥ 1.0

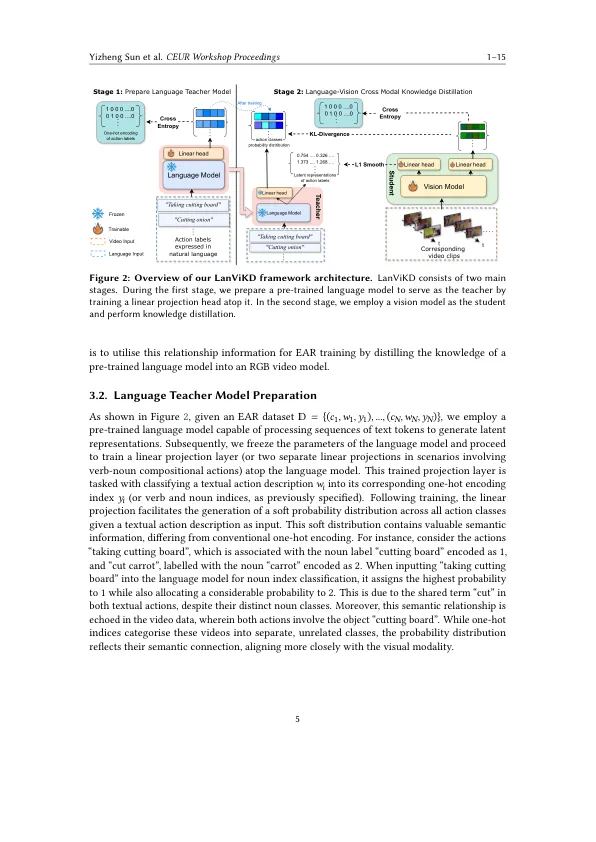

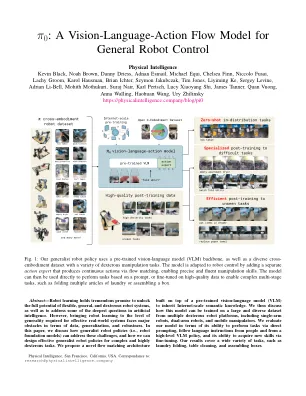

通过分析以自我为中心的视频的分析,抽象理解人类行动是智能代理人的理想能力,并且是一个最近越来越受欢迎的研究领域。到目前为止,大多数以自我为中心的(视频)动作识别(EAR)的方法,即,根据预定义的自然语言描述(动作)对给定的视频剪辑进行分类的任务,代表目标动作类(标签)使用一个hot编码,从而忽略了某些动作之间的任何关系或相似性。这项工作的目标是通过利用预先训练的语言模型中编码的先前存在的知识来增强视觉模型的概括能力。具体来说,我们提出了一个语言知识蒸馏框架,以将预训练的语言模型对动作(文本中表达)的知识(在文本中表达)提高到视觉模型。我们不使用标签的单热编码表示,而是将所有动作类别(由语言模型构成)的概率分布作为教学信号。我们的实验表明,我们的框架根据Epic-Kitchens,Something of Something V2等基准获得了EAR的性能和泛化能力。

lanvikd:以自我为中心动作识别的跨模式语言知识蒸馏

主要关键词