机构名称:

¥ 1.0

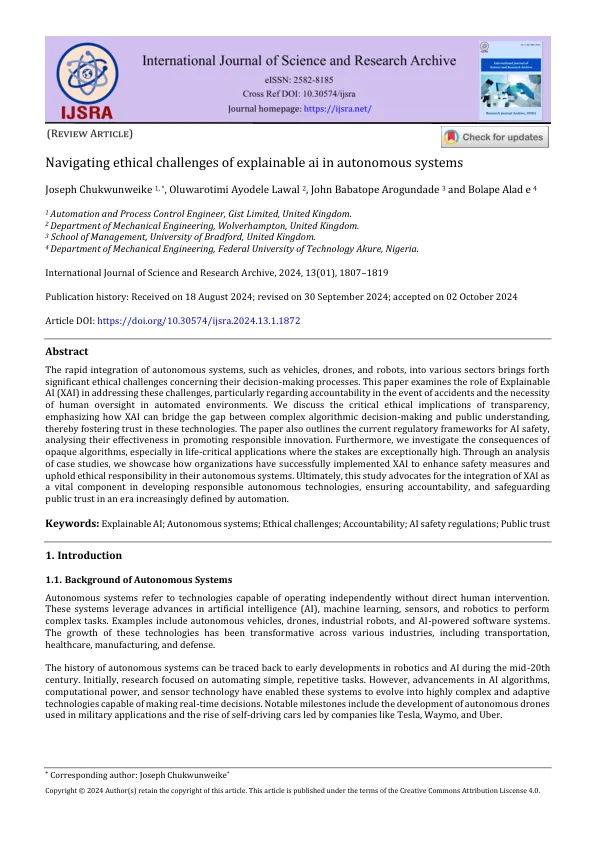

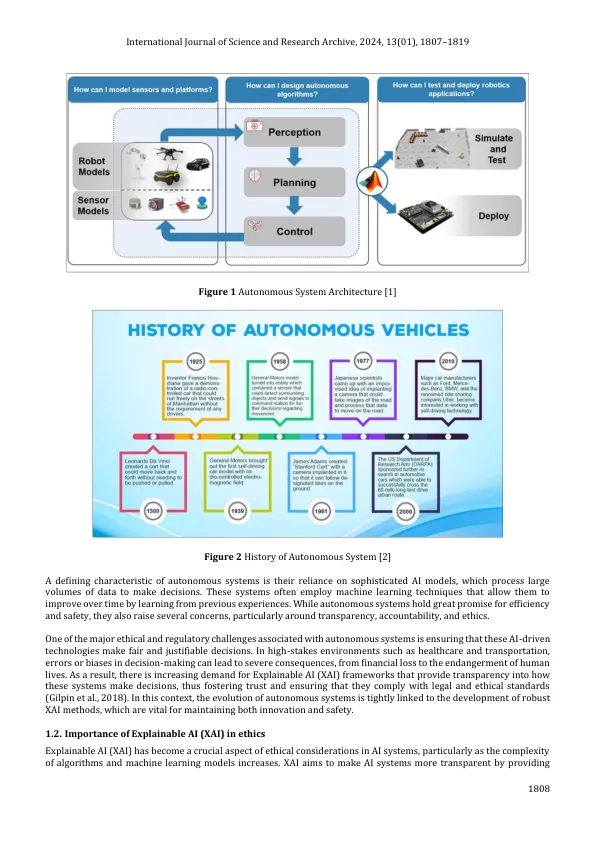

自主系统(例如车辆,无人机和机器人)迅速整合到各个部门中,带来了有关其决策过程的重大道德挑战。本文研究了可解释的AI(XAI)在解决这些挑战中的作用,尤其是在发生事故的问责制以及在自动化环境中人类监督的必要性方面的作用。我们讨论了透明度的关键道德含义,强调了Xai如何弥合复杂算法的决策和公众理解之间的差距,从而促进了对这些技术的信任。本文还概述了当前的AI安全监管框架,分析了它们在促进负责任创新方面的有效性。此外,我们研究了不透明算法的后果,尤其是在赌注异常高的生命危机应用中。通过对案例研究的分析,我们展示了组织如何成功实施XAI,以增强其自主系统中的安全措施并维护道德责任。最终,本研究主张将XAI作为发展负责任的自主技术的重要组成部分,确保问责制和维护越来越定义的自动化定义的时代。

在自主系统中引起可解释AI的道德挑战

主要关键词