机构名称:

¥ 2.0

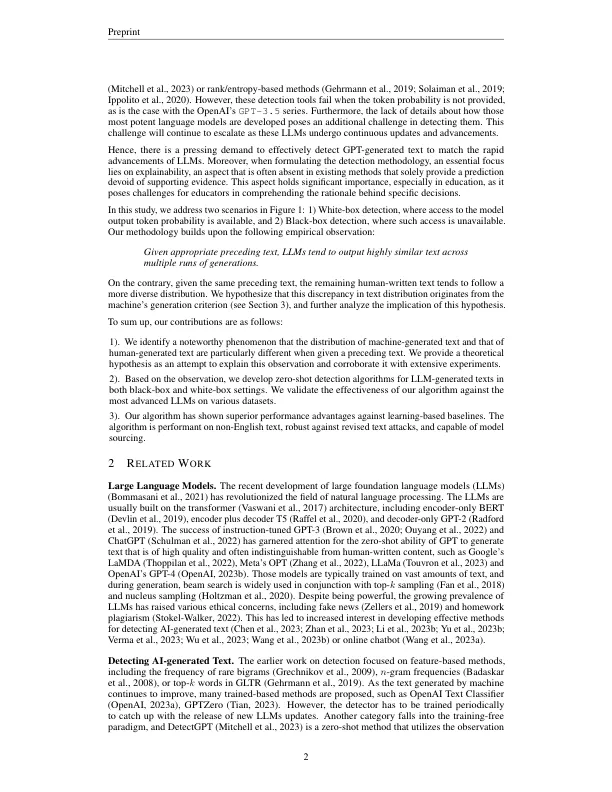

大型语言模型(LLMS)显着增强了机器生成的文本的流畅性和多样性。然而,这一进展在检测给定文本的起源方面也提出了重大挑战,并且有关检测方法的当前研究滞后于LLM的快速发展。传统的基于培训的方法在灵活性方面存在局限性,尤其是在适应新领域时,并且通常缺乏解释性的能力。为了解决这一差距,我们提出了一种新型的无训练检测策略,称为d ivergent n-gram a nalysis(DNA-gpt)。给定文本,我们首先将其截断在中间,然后仅将上述部分作为LLMS输入以重新生成新的剩余部分。通过在黑盒中分析原始部分和新的部分之间的差异,或者在白框中的概率差异,我们在机器生成的文本的分布与人类写入的文本的分布之间公布了显着差异。我们对Openai最先进的LLM进行了广泛的实验,包括Text-Davinci-003,GPT-3.5-Turbo和GPT-4,以及诸如GPT-Neox-20B和Llama-13b之类的开源模型。的结果表明,我们的零射击方法在区分四个英语和一个德国数据集的人类和GPT生成的文本方面表现出最先进的表现,表现优于Openai自己的分类器,该分类器对数百万文本进行了培训。另外,我们的方法提供了合理的解释和证据来支持我们的主张,这是可解释检测的独特特征。代码可从https://github.com/xianjun-yang/dna-gpt在修订后的文本攻击下,我们的方法也很强,可以另外解决模型采购。

DNA-GPT

主要关键词