机构名称:

¥ 1.0

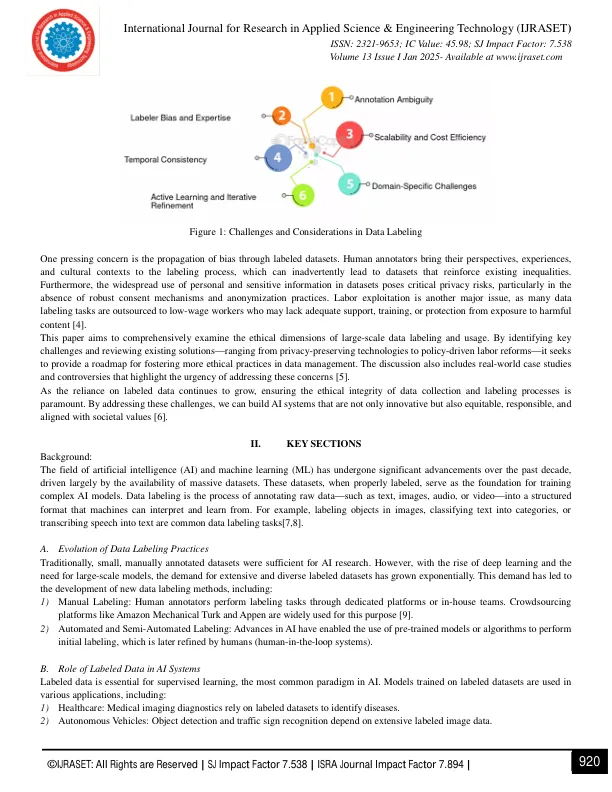

2科学技术学院,Qaminis 3高级科学与技术研究院,Alqarayt摘要:人工智能(AI)和机器学习(ML)的迅速采用已经创造了对高质量标记数据的前所未有的需求。大规模数据标记是AI系统开发的关键组成部分,通常涉及来自不同人群的大量数据集,并使用自动化过程和人工劳动的结合进行了注释。但是,与这些实践相关的道德挑战引起了极大的关注。本文探讨了大规模数据标签和用法中的关键道德问题,重点关注四个关键领域:偏见,隐私,劳动实践和透明度。偏见是由注释者的固有主观性和许多数据集的不代表性产生的,这加剧了AI应用程序中不公平或歧视性结果的风险。侵犯隐私性侵犯敏感信息未经适当同意而使用,通常会挑战匿名技术的有效性。此外,对数据注释的众包劳动力的依赖引起了人们对工人剥削,低补偿和标记敏感或明确内容的心理损失的担忧。最后,数据收集和标签过程中缺乏透明度和问责制破坏了公共信任和道德标准。通过对现有实践的全面审查,本文重点介绍了现实世界中的案例研究和争议,包括偏见的数据集和侵犯隐私行为。当前的技术和政策驱动的解决方案(例如隐私的技术,劳动力改革和缓解偏见的算法)都经过了严格的研究。最后,本文讨论了按大规模实施这些解决方案并确定未来研究方向的挑战。通过解决这些问题,这项工作旨在在AI数据管理的生命周期中促进更公平,透明和道德实践。关键字:伦理AI,数据标记,机器学习中的偏见,AI隐私,众包数据注释,数据透明度,算法公平,负责任的AI实践,联邦学习,差异性学习,数据伦理,数据伦理,注释者,注释者,注释者单位,AI政,数据隐私法规,数据隐私规定,可持续的AI开发。

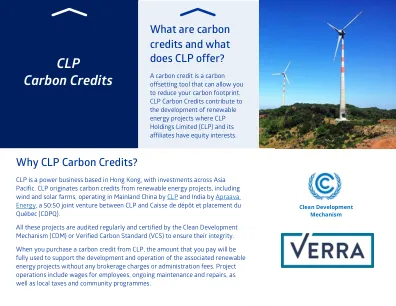

基于区块链的碳信用生态系统

主要关键词