机构名称:

¥ 7.0

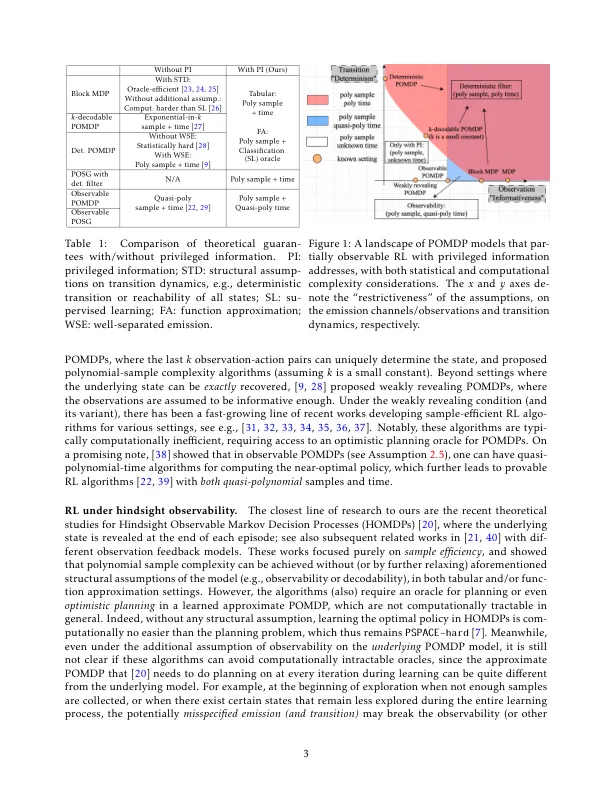

基础状态的部分可观察性通常对控制学习(RL)提出了重大挑战。实际上,某些特权信息,例如,从模拟器中访问州的访问已在培训中得到利用,并取得了杰出的经验成功。为了了解特权信息的好处,我们在这种情况下重新访问并检查了几个简单且实际使用的范例。具体来说,我们首先正式化了专家蒸馏的经验范式(也称为教师学习),证明了其在发现近乎最佳政策时的陷阱。然后,我们确定部分可观察到的环境的条件,即确定性的滤波器条件,在该条件下,专家蒸馏实现了两个多项式的样品和计算复杂性。此外,我们研究了不对称参与者 - 批评者的另一个有用的经验范式,并专注于更具挑战性的可观察到的部分可观察到的马尔可夫决策过程。我们开发了一种具有多项式样本和准多项式计算复杂性的信念加权不对称的演员算法,其中一个关键成分是一种新的可培养的甲骨文,用于学习信念,可在不指定的模型下保留过滤器稳定性,这可能是独立的。最后,我们还可以使用特权信息来介绍部分可观察到的多代理RL(MARL)的可证明的效率。与最近的一些相关理论研究相比,我们的重点是理解实际启发的算法范式,而无需进行棘手的甲壳。我们开发了具有集中式训练 - 二级化 - 执行的算法,这是经验MARL中的流行框架,具有多项式样本和(Quasi-)多项式组成的复杂性,在上述两个范式中。

可证明可以通过...

主要关键词