机构名称:

¥ 1.0

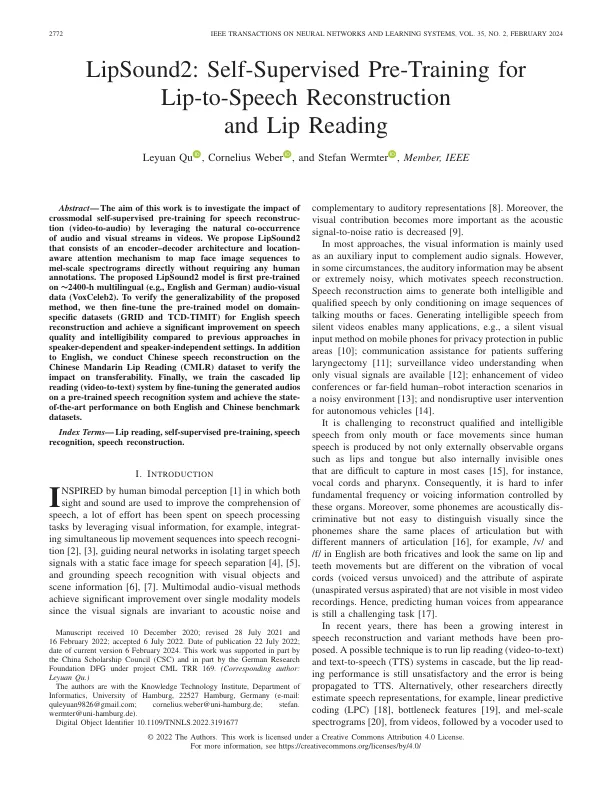

摘要 - 这项工作的目的是通过利用视频中音频和视觉流的自然共发生来研究跨模式自我监管的预训练对语音重新构造的影响。我们提出的LIPSOUND2由编码器 - 二次结构和位置意识到的注意机制组成,以将面部图像序列映射到MEL尺度频谱图,而无需任何人类注释。提出的LIPSOUND2模型是在〜2400-h多语言(例如英语和德语)音频数据(Voxceleb2)上首次预先训练。为了验证所提出的方法的普遍性,我们随后在域特异性数据集(网格和TCD-TIMIT)上进行了预训练的模型,以进行英语语音重建,并与依赖于讲话者依赖于依赖于讲话者的依赖于讲话者的言语质量和清晰度相比,对语音质量和清晰度的改善显着提高。除了英语外,我们还对中国普通话唇读(CMLR)数据集进行了中文语音重建,以验证对可转移性的影响。最后,我们通过在预先训练的语音识别系统上培养生成的音频并在英语和中文基准数据集上实现状态性能来训练级联的唇读(视频对文本)系统。

lipsound2:自我监督的嘴唇到语音重建和唇读的预训练

主要关键词