机构名称:

¥ 1.0

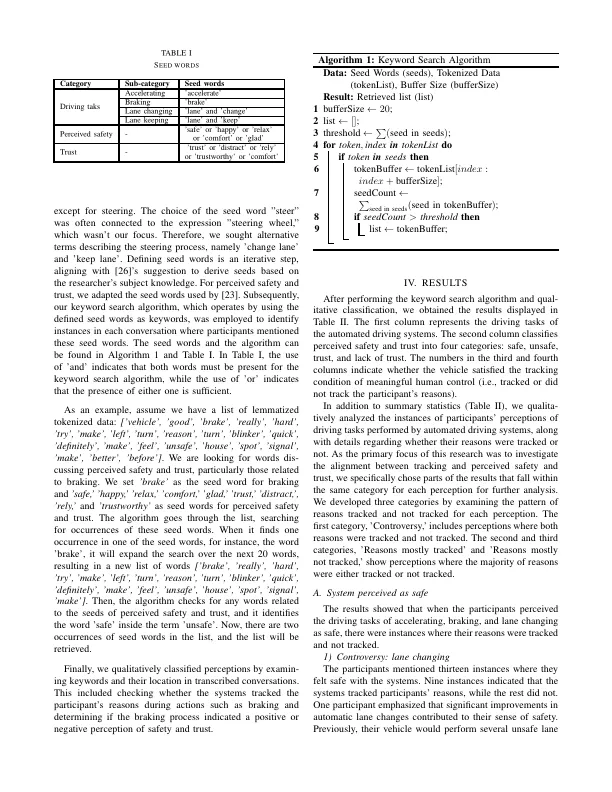

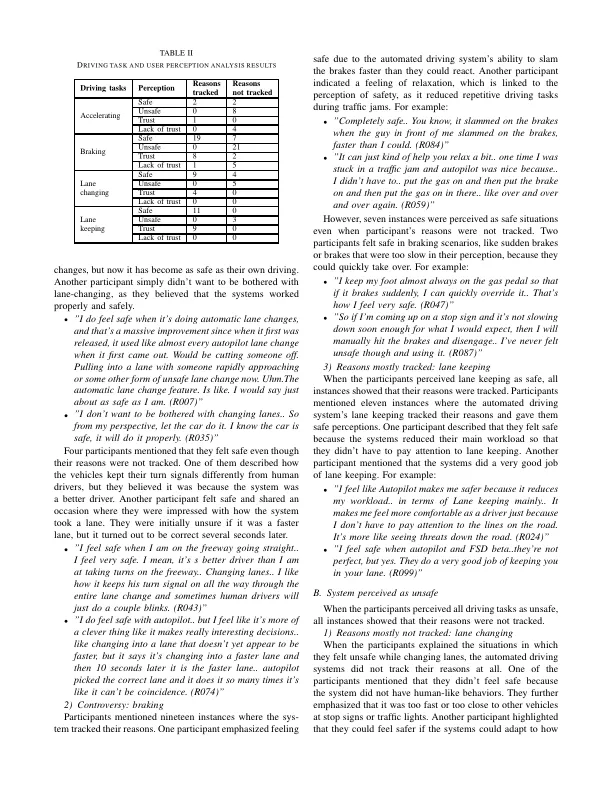

摘要 - 使用部分自动化的驾驶系统的使用引起了人们对潜在责任问题的担忧,对系统安全,接受和采用这些技术构成风险。有意义的人类控制的概念是针对责任差距问题的响应,重新填写了两个条件,跟踪和追踪。这个概念为自动驾驶系统提供了重要的哲学和设计见解,但目前对有意义的人类控制如何与这些系统的实际用户的主观体验相关的知识很少。为了解决这一差距,我们的研究旨在调查有意义的人类控制程度与驾驶员对现实世界中部分自动驾驶系统安全和信任的看法之间的一致性。我们利用了先前从特斯拉“全自动驾驶”(FSD)beta用户的访谈中收集的数据,研究了用户感知之间的一致性以及系统跟踪用户的原因。我们发现,尽管有明显的例外,但跟踪用户驾驶任务的原因(例如安全操作)与感知的安全和信任相关。令人惊讶的是,未能跟踪车道变化和制动原因不一定与对安全性的负面看法有关。但是,在危险情况下,系统未能跟踪预期的操作总是会导致信任低下,缺乏安全性。总的来说,我们的分析重点介绍了对齐点,但一方面,感知到的安全性和信任和有意义的人类控制也可能存在差异。我们的结果可以帮助自动化驾驶技术的开发商在有意义的人类控制下设计系统,并被认为是安全和值得信赖的。

用户对部分自动化驾驶系统的看法

主要关键词