机构名称:

¥ 1.0

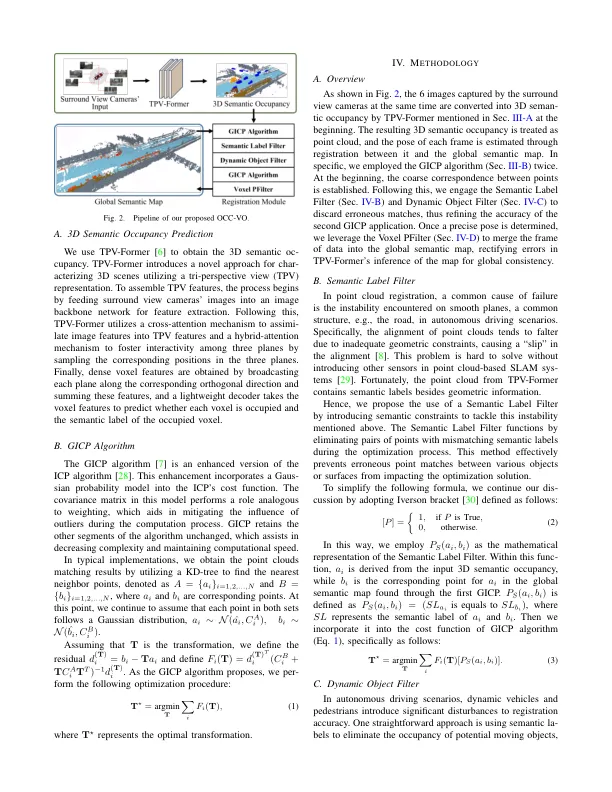

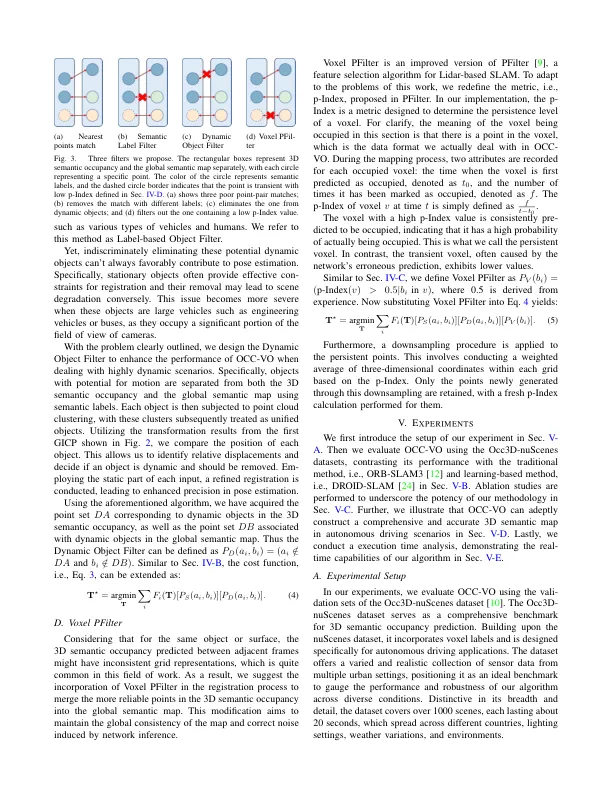

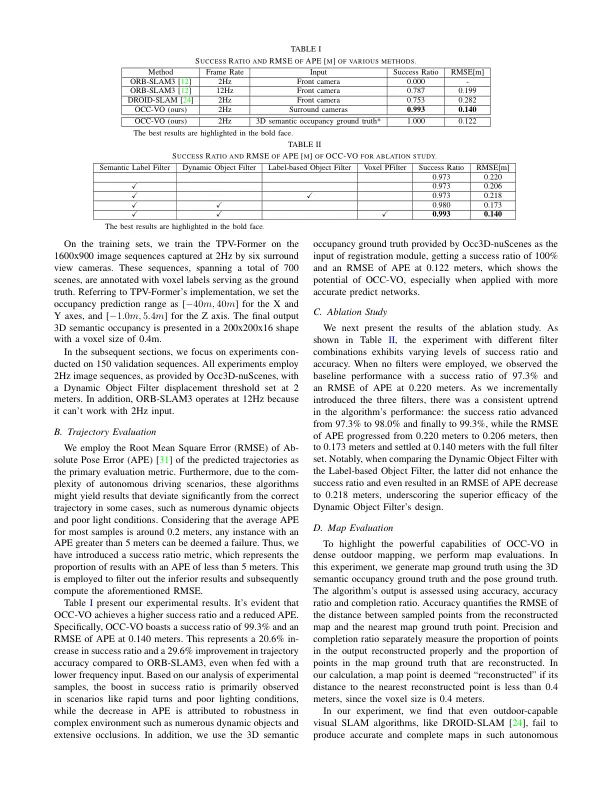

摘要 - 视觉进程(VO)在自主系统中起关键作用,主要挑战是相机图像中缺乏深度信息。本文介绍了OCC-VO,这是一个新颖的框架,该框架利用了深度学习的最新范围,将2D摄像机图像转换为3D语义占用,从而规定了传统的同时估计自我姿势和地标地点的需求。在此框架内,我们利用TPV形式将环绕摄像机的图像转换为3D语义占用。解决了这种转换所带来的挑战,我们专门为姿势估计和映射算法定制,该算法结合了语义标签滤波器,动态对象滤波器,最后利用Voxel Pfilter来维护一致的全局语义映射。对OCC3D-NUSCENES的评估不仅展示了成功率提高了20.6%,并且针对ORB-SLAM3的轨迹精度提高了29.6%,而且还强调了我们构建全面地图的能力。我们的实施是开源的,可在以下网址提供:https://github.com/ustclh/occ-vo。

occ-vo:通过基于3D占用率的视觉探针的密集映射用于自动驾驶