机构名称:

¥ 1.0

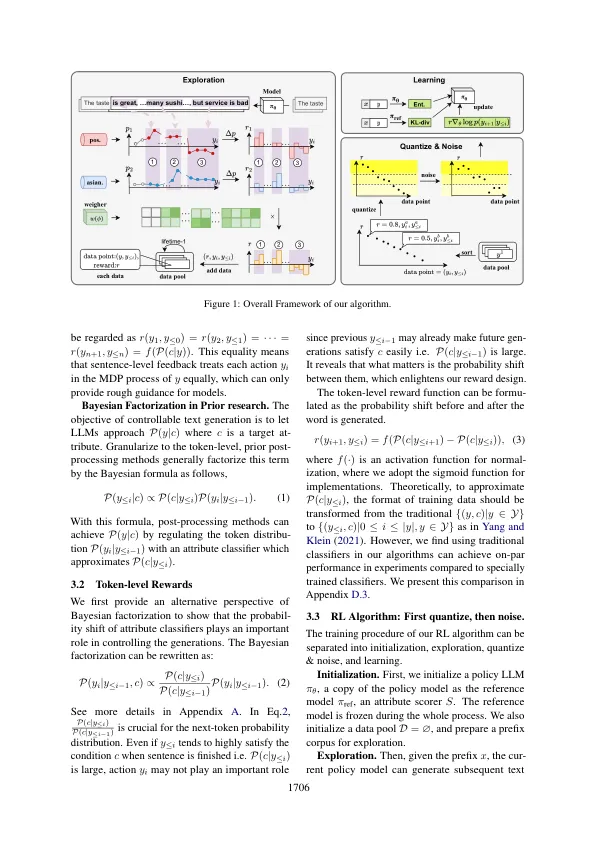

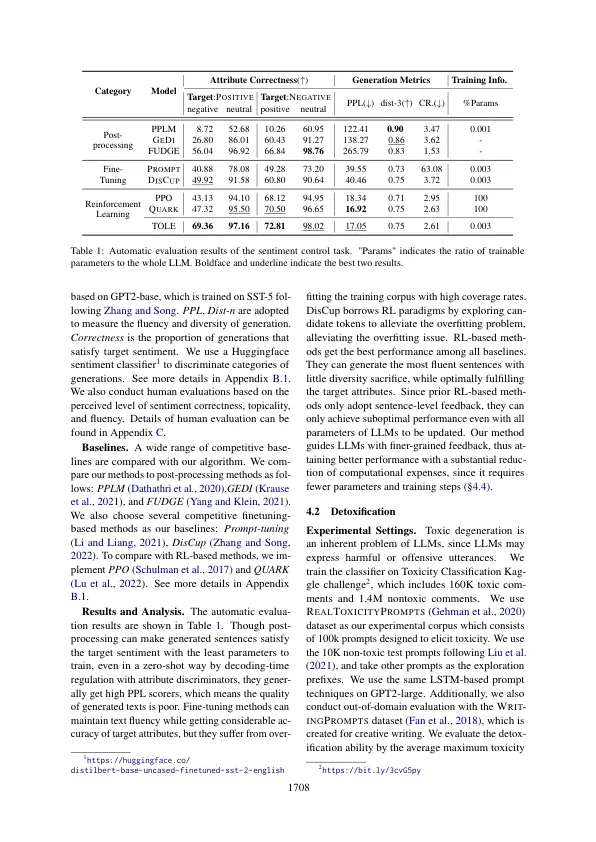

为了满足现实世界应用的要求,控制几代大语言模型(LLMS)至关重要。先前的研究试图将强化学习(RL)引入可控制的文本生成中,而大多数现有的方法都遭受了过度拟合问题(基于芬太尼的方法)或半崩溃(后处理方法)。但是,当前的RL方法通常由粗粒(句子/段落级)的反馈引导,这可能导致由于语义曲折或句子中的序言而导致次优的表现。为了解决这个问题,我们提供了一种新颖的增强学习算法,名为Tole,该算法为Kenle Vel Rewards制定了可控的文本生成,并采用了“首次量化 - 涉及的”范式来增强RL算法的鲁棒性。此外,TOLE可以灵活地扩展到多个约束,而计算费用很少。实验结果表明,我们的算法可以在单属性和多属性控制任务上实现出色的性能。我们已在https://github.com/windylee0822/ctg上发布了代码。

使用令牌级的加固学习,用于可控文本生成

主要关键词