机构名称:

¥ 1.0

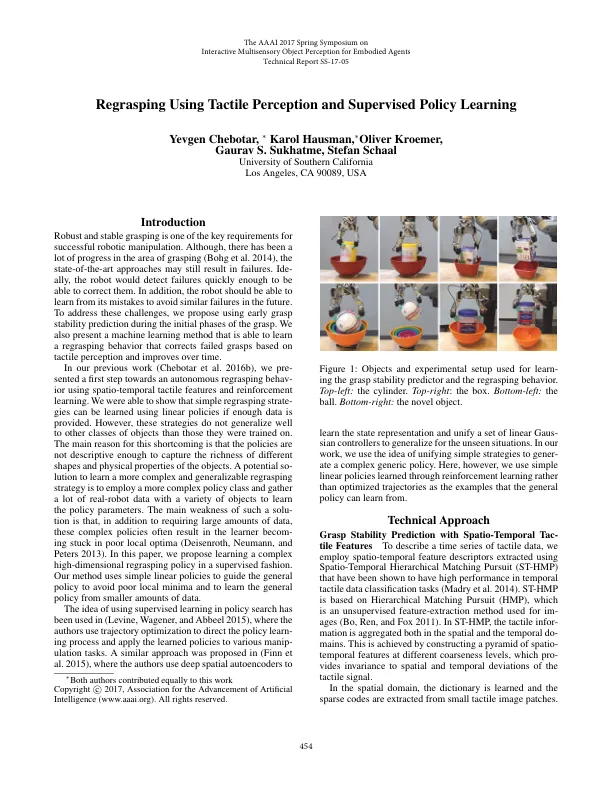

引言强大而稳定的抓握是成功机器人操作的关键要求之一。尽管在抓住领域取得了很大进步(Bohg等人2014),最新方法仍可能导致失败。iDe,机器人将足够快地检测出故障以纠正它们。此外,机器人应该能够从错误中学习,以避免将来的类似失败。为了应对这些挑战,我们建议在掌握的初始阶段使用早期的掌握稳定性预测。我们还提出了一种机器学习方法,该方法能够学习一种基于触觉感知并随着时间的推移而改善的纠正失败的graSps行为。在我们以前的工作中(Chebotar等人2016b),我们迈出了使用时空触觉特征和增强学习的第一步,朝着自主重新审向行为。我们能够证明,如果提供了足够的数据,则可以使用线性策略来学习简单的重新制定策略。但是,这些策略并不能比接受过培训的策略对其他类别的对象进行概括。造成这种缺点的主要原因是策略不足以捕获对象的不同形状和物理特性的丰富性。学习一个更复杂且可推广的策略的潜在可能是采用更复杂的政策类别,并收集许多带有各种对象的现实机器人数据来学习策略参数。在中提出了类似的方法(Finn等人这种解决方案的主要弱点是,除了需要大量数据外,这些复杂的政策通常会导致学习者陷入贫困的本地优点(Deisenroth,Neumann和Peters 2013)。在本文中,我们建议以监督的方式学习一项复杂的高维重新制定政策。我们的方法使用简单的线性策略来指导一般政策,以避免本地最小值差,并从较少的数据中学习一般政策。在政策搜索中使用监督学习的想法已在(Levine,Wagener和Abbeel 2015)中使用,在该搜索中,作者使用轨迹优化来指导政策学习过程,并将学习的政策应用于各种操纵任务。2015),作者在

使用触觉感知和监督政策学习

主要关键词