机构名称:

¥ 1.0

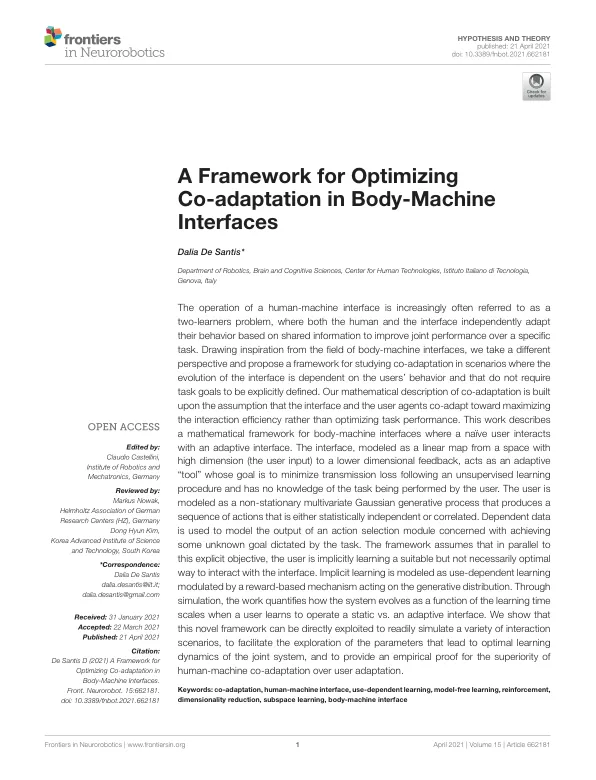

人机界面的操作越来越多地被称为双学习者问题,其中人和界面都基于共享信息独立调整其行为,以提高特定任务的联合性能。从人体机界面领域汲取灵感,我们采取不同的视角,并提出了一个框架,用于研究在界面的演变取决于用户的行为并且不需要明确定义任务目标的情况下的协同适应。我们对协同适应的数学描述建立在以下假设之上:界面和用户代理共同适应以最大化交互效率而不是优化任务性能。这项工作描述了人体机界面的数学框架,其中天真的用户与自适应界面交互。界面被建模为从高维空间(用户输入)到低维反馈的线性映射,充当自适应“工具”,其目标是在无监督学习过程之后最大限度地减少传输损耗,并且不知道用户正在执行的任务。用户被建模为非平稳多元高斯生成过程,该过程产生一系列统计上独立或相关的动作。依赖数据用于建模与实现任务规定的某些未知目标有关的动作选择模块的输出。该框架假设,与此明确目标并行,用户正在隐性学习一种合适但不一定是最佳的与界面交互的方式。隐性学习被建模为使用依赖性学习,由作用于生成分布的基于奖励的机制调节。通过模拟,该工作量化了当用户学习操作静态界面与自适应界面时,系统如何根据学习时间尺度演变。我们表明,可以直接利用这个新框架来轻松模拟各种交互场景,以促进对导致联合系统最佳学习动态的参数的探索,并为人机协同适应优于用户适应提供经验证明。

优化身体相互适应的框架......

主要关键词