机构名称:

¥ 1.0

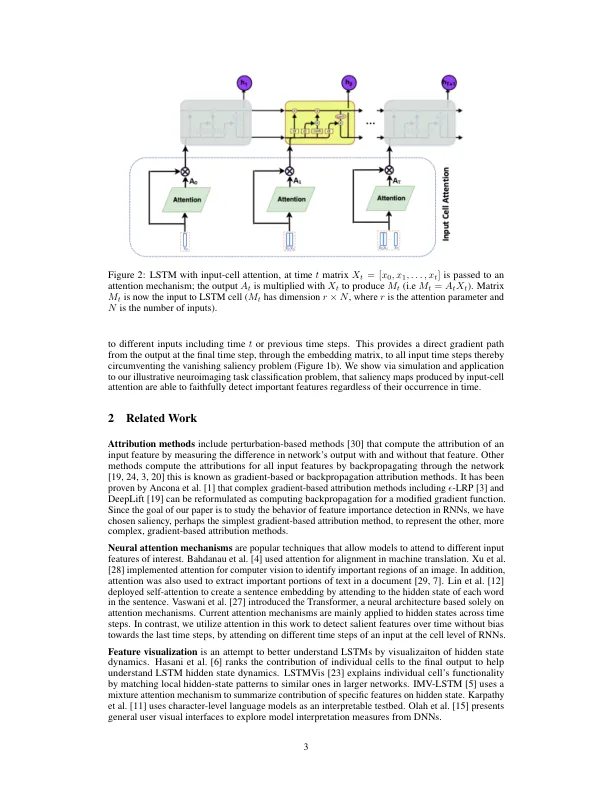

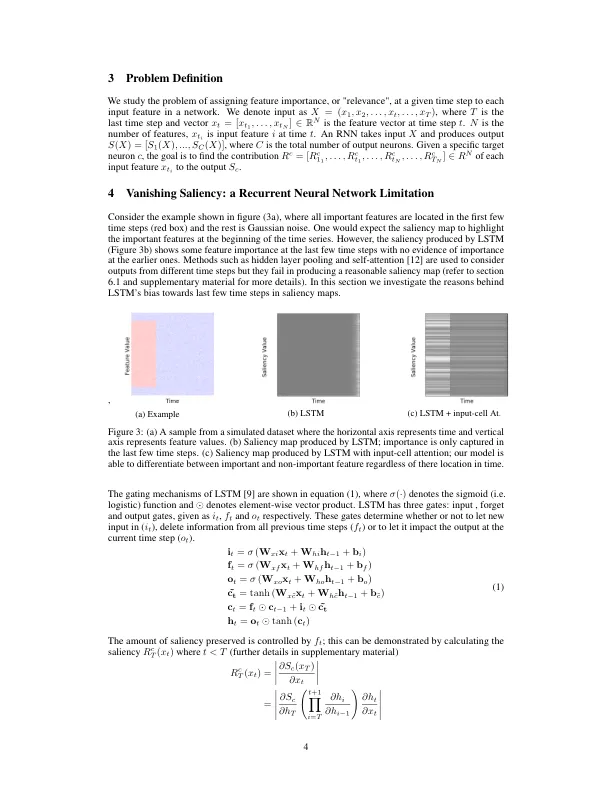

最近,为提高深度神经网络的可解释性,人们使用显著性来表征输入特征对模型预测的重要性。在循环神经网络 (RNN) 上使用基于显著性的方法进行可解释性研究主要针对语言任务,而它们对时间序列数据的适用性尚不明确。在本文中,我们分析了基于显著性的 RNN 方法,包括经典和门控单元架构。我们表明,RNN 显著性会随着时间的推移而消失,导致对显著特征的检测仅偏向于后续时间步骤,因此无法可靠地检测任意时间间隔内的重要特征。为了解决这个显著性消失问题,我们提出了一种新颖的 RNN 单元结构(输入单元注意力†),它可以扩展任何 RNN 单元架构。在每个时间步骤,输入单元注意力使用固定大小的矩阵嵌入,而不是只查看当前输入向量,矩阵的每一行都关注来自当前或之前时间步骤的不同输入。使用合成数据,我们表明,输入单元注意 RNN 生成的显着性图能够忠实地检测重要特征,无论它们在时间上发生如何。我们还将输入单元注意 RNN 应用于神经科学任务,该任务分析执行各种任务的人类受试者的功能性磁共振成像 (fMRI) 数据。在这种情况下,我们使用显着性来表征大脑区域(输入特征),这些区域的活动对于区分任务很重要。我们表明,标准 RNN 架构只能在 fMRI 数据的最后几个时间步骤中检测重要的大脑区域,而输入单元注意模型能够跨时间检测重要的大脑区域活动,而不会在后面的时间步骤中产生偏差。

输入细胞注意力机制降低循环神经网络的消失显着性

主要关键词