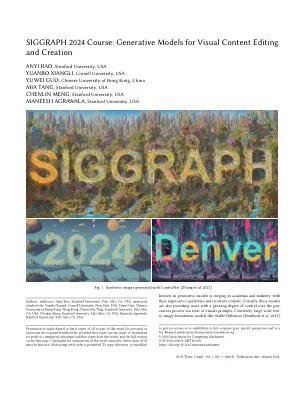

sdxl [Podell等。2023],Ediff-i [Balaji等。2022],dall-e 3 [Betker等。2023];文本到视频基础模型,例如Imagen视频[Ho等。2022]和Make-A-Video [Singer等。2022],Sora [OpenAI 2024]增强了视觉内容编辑和发电的增长。代表性地,例如Animatediff [Guo等人。2023],ControlNet [Zhang等。2023]具有不同用户定义条件的视频创建,并已成为用于图形设计和个性化媒体的实用工具。在忠诚度和效率方面,3D资产产生也有一场革命。收获2D扩散模型的强大先验,例如DreamFusion [Poole等。2022],魔术3D [Lin等。2023],Zero123 [Liu等。2023],Wonder3d [Long等。 2023]被启用了高质量的文本和图像到3D对象生成,具有合理的几何形状和物理属性,以支持它们在游戏和仿真任务中的用法。 同时,高质量的大规模3D数据的出现[Deitke等。 2023a,b; Yu等。 2023]还授权了3D空间中的直接生成模型训练[Hong等。 2023; Xu等。 2023]。 受到3D资产产生成功的启发,场景级别的3D合成也引起了人们的兴趣。 诸如genvs之类的工作[Chan等。 2023],重新灌注[Wu等。 2023]还受益于2D扩散先验,以实现高质量的新型视图综合。 2023],块平面[Xu等。2023],Wonder3d [Long等。2023]被启用了高质量的文本和图像到3D对象生成,具有合理的几何形状和物理属性,以支持它们在游戏和仿真任务中的用法。同时,高质量的大规模3D数据的出现[Deitke等。2023a,b; Yu等。2023]还授权了3D空间中的直接生成模型训练[Hong等。2023; Xu等。2023]。受到3D资产产生成功的启发,场景级别的3D合成也引起了人们的兴趣。诸如genvs之类的工作[Chan等。2023],重新灌注[Wu等。2023]还受益于2D扩散先验,以实现高质量的新型视图综合。2023],块平面[Xu等。工作的另一个分支,例如Assetfield [Xiangli等。2021]将场景视为由布局引导的3D资产的组成,可以用数据驱动的方式对其进行建模,同时保证用户可控性。本课程涵盖了过去几年的生成模型的进步,略微转向生成模型实现的可控性和创造力任务。我们将首先介绍与生成模型相关的基本机器学习和深度学习技术。接下来,我们将展示可控图像,视频和3D内容生成和组成表示学习中的最新代表性工作。最后,我们将在讨论该技术,社会影响和开放研究问题的未来应用的讨论中结束。课程结束后,与会者将学习有关扩散模型的基本知识,以及如何将这些模型应用于不同的应用程序。P.S. 网站:https://cveu.github.io/event/sig2024.html; Twitter:https://twitter.com/cveu_workshopP.S.网站:https://cveu.github.io/event/sig2024.html; Twitter:https://twitter.com/cveu_workshop

视觉内容编辑和创建的生成模型

主要关键词