机构名称:

¥ 1.0

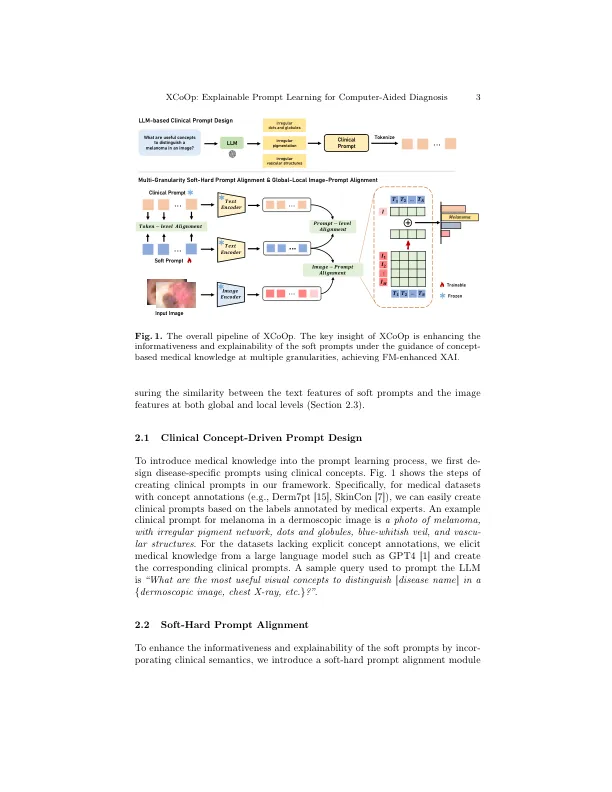

摘要。利用大型视觉模型(VLM)的有效表示来完成各种下游任务,引起了人们越来越多的关注。在该研究领域中,软提示学习已成为有效地适应VLM(例如剪辑)的代表性方法,例如图像分类。但是,大多数现有的及时学习方法都学习无法解释的文本令牌,这些文本令牌无法满足医疗保健等高风险场景中可解释的人工智能(XAI)的严格解释性要求。为了解决这个问题,我们提出了一个新颖的可解释的提示学习框架,该框架通过在多个差异方面对齐图像,可学习的提示和临床概念驱动的提示来利用医学知识。此外,我们的框架通过从大型语言模型中引起知识来解决缺乏宝贵的概念注释,并为提示提供了视觉和文字解释。在各种数据集上进行的广泛的实验和可解释性分析,有或没有概念标签,表明我们的方法同时实现了卓越的诊断性能,灵活性和解释性,并阐明了基础模型在促进XAI方面的有效性。该代码可在https://github.com/tommy-bie/xcoop上找到。

XCOOP:通过概念引导的上下文优化的计算机辅助诊断的可解释及时学习

主要关键词