机构名称:

¥ 1.0

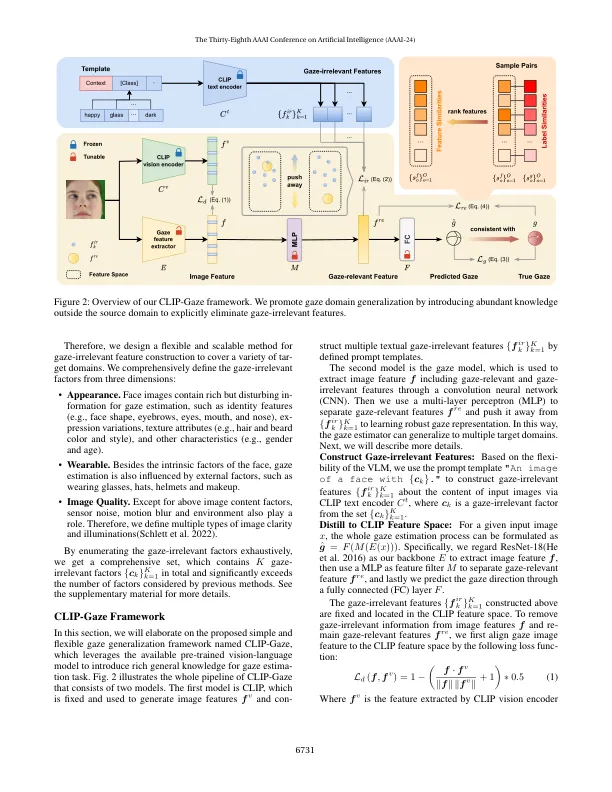

凝视估计方法由于测试和训练数据之间的域间隙,在跨不同领域进行评估时,经常会出现明显的表现降解。现有方法试图使用各种主要的概括方法来解决此问题,但由于凝视数据集的多样性有限,例如外观,可穿戴和图像质量,因此很少成功。为了克服这些限制,我们提出了一个名为Clip Gaze的新型框架,该框架利用预先训练的视觉模型来利用其可转移的知识。我们的框架是第一个利用视觉和语言跨模式的方法来进行凝视任务。具体来说,我们通过将其从凝视式的功能推开,可以通过语言描述灵活构建,从而提取了与凝视的功能。要学习更多合适的提示,我们建议一种个性化的上下文优化方法,以提示提示。此外,我们还利用凝视样本之间的关系来完善视线相关特征的分布,从而提高了凝视估计模型的概括能力。的实验实验表明,在四个跨域评估上,夹具凝视的表现出色。

通过推断出明显的摘要 - 特征夹子凝视:通过视觉语言模型进行一般凝视估计