机构名称:

¥ 1.0

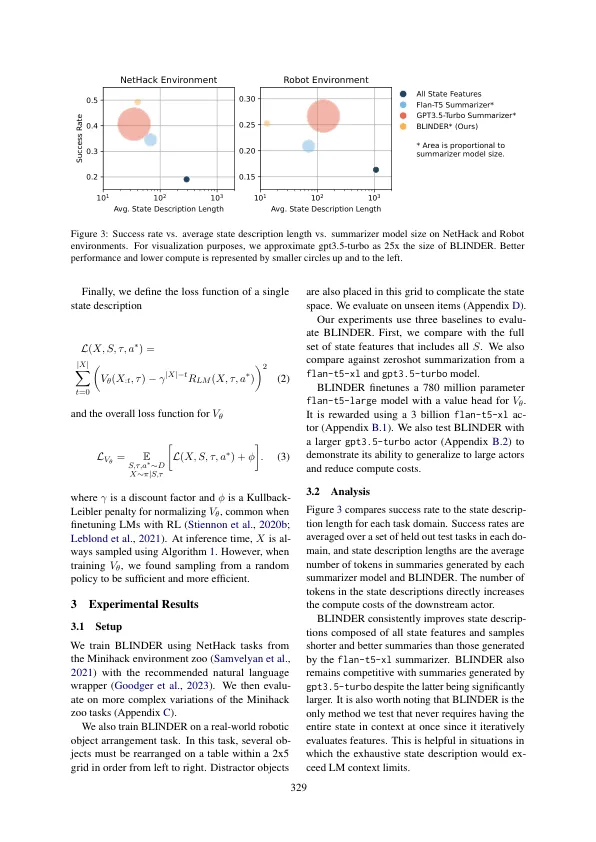

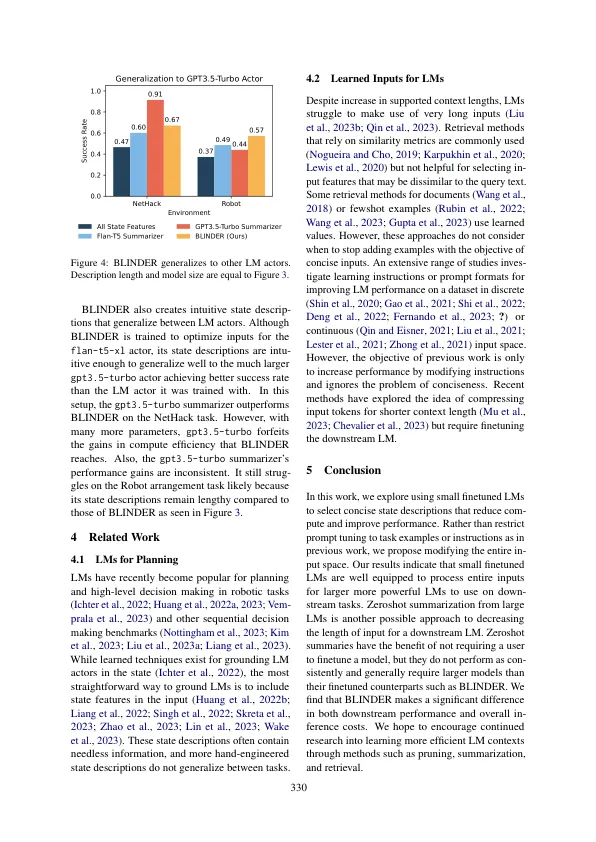

最新的大型语言模型(LMS)越来越长的上下文。虽然这种趋势允许使用大量的SOTA LMS使用大量文本,但要求这些大的LMS处理潜在的冗余或无关紧要的数据,可以不必要地增加推理时间和成本。为了解决这个问题,我们提出了Blinder,该方法利用了一个小的易键率LM来采样最小的Inter功能集,从而最大程度地提高了下游LM的性能。Blinder训练具有价值头的LM,以估算下游LM的最佳输出的可能性。我们评估了盲目的盲目决策制定任务,该任务臭名昭著,臭名昭著的状态描述:nethack和机器人计划。Blinder在Nethack和Robot Planning中分别将LM Actor In-Actor In-In-Actor In-In-Actor In-In-Actor In-In-flongion降低了158%和54%,这分别代表了大量推断成本节省,同时又代表了绩效的提高。

选择性感知:学习语言模型演员的简洁状态描述

主要关键词