机构名称:

¥ 1.0

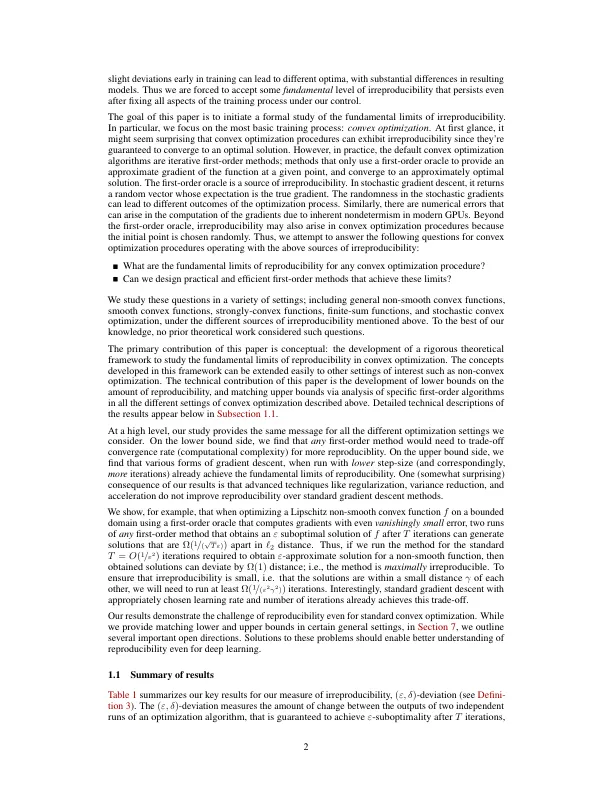

除了机器学习模型的实际部署之外,机器学习学术界的可重复性危机也得到了充分的记录:请参阅 [ Pineau 等人,2021 ] 及其参考文献,其中对不可重复性的原因(对超参数和实验设置的探索不足、缺乏足够的文档、代码无法访问以及不同的计算硬件)进行了出色的讨论,并提出了缓解建议。最近的论文 [ Chen 等人,2020 、D'Amour 等人,2020 、Dusenberry 等人,2020 、Snapp 和 Shamir,2021 、Summers 和 Dinneen,2021 、Yu 等人,2021 ] 还证明,即使在相同的数据集上使用相同的优化算法、架构和超参数训练模型,它们也会对同一个示例产生明显不同的预测。这种不可重复性可能是由多种因素造成的 [D'Amour 等人,2020 年,Fort 等人,2020 年,Frankle 等人,2020 年,Shallue 等人,2018 年,Snapp 和 Shamir,2021 年,Summers 和 Dinneen,2021 年],例如目标的非凸性、随机初始化、训练中的不确定性(例如数据混洗)、并行性、随机调度、使用的硬件和舍入量化误差。也许令人惊讶的是,即使我们通过使用相同的“种子”进行模型初始化来控制随机性,其他因素(例如由于现代 GPU 的不确定性而引入的数值误差)(参见,例如,[ Zhuang et al. , 2021 ])仍可能导致显着差异。经验表明(参见,例如,Achille et al. [ 2017 ])

优化中的可重复性:理论框架和局限性

主要关键词