机构名称:

¥ 1.0

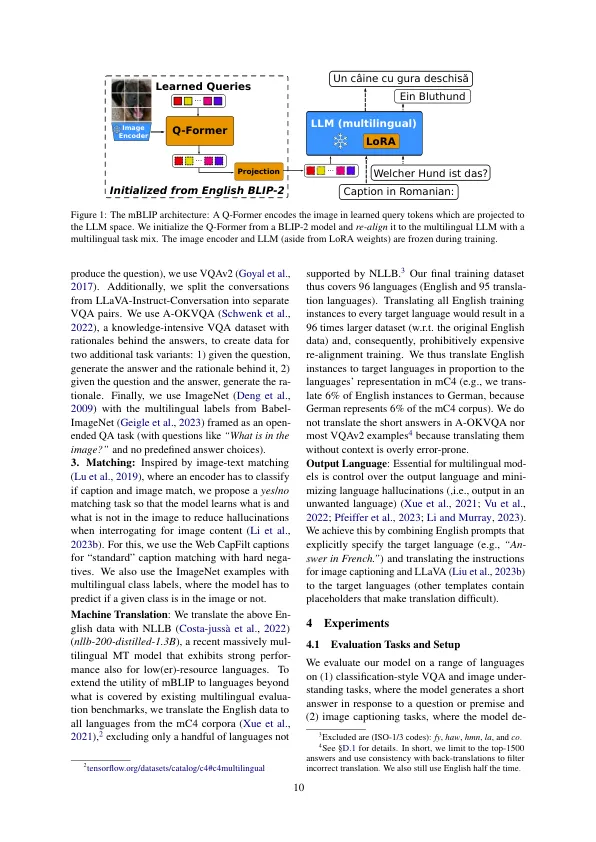

模块化视觉模型(视觉-LLM)与(冷冻)大语言模型(LLMS)和事后状况LLMS对齐图像编码器,以“理解”图像输入。随着丰富的高质量英语图像文本数据以及强大的单语英文LLM的丰富性,研究重点一直放在英语的视觉上。多语言视觉语言模型仍主要通过昂贵的端到端预审计获得,从而产生了相对较小的模型,该模型接受了培训的多语言图像数据,并补充了仅文本的多语言语料库。我们提出了MBLIP,这是第一个Vision-Llm利用Mul-litsiantual LLM,我们以构成有效的方式在消费者级硬件上获得。为此,我们将先前调整为英文LLM调整为新的多语言LLM的图像编码器仅使用几百万个多语言培训示例,这些训练示例来自视觉和语言任务的组合,我们通过机器转换为95种语言而获得的高质量的英语数据。在Iglue基准和XM3600上,MBLIP产生与最先进的mod-els竞争的重新竞争,它极大地超过了强大的英语 - 仅有llava 1.5的视觉效果。我们在https://github.com/gregor-ge/mblip上发布了模型,代码和火车数据。

mblip:多语言视觉-LLMS的有效自举

主要关键词