机构名称:

¥ 1.0

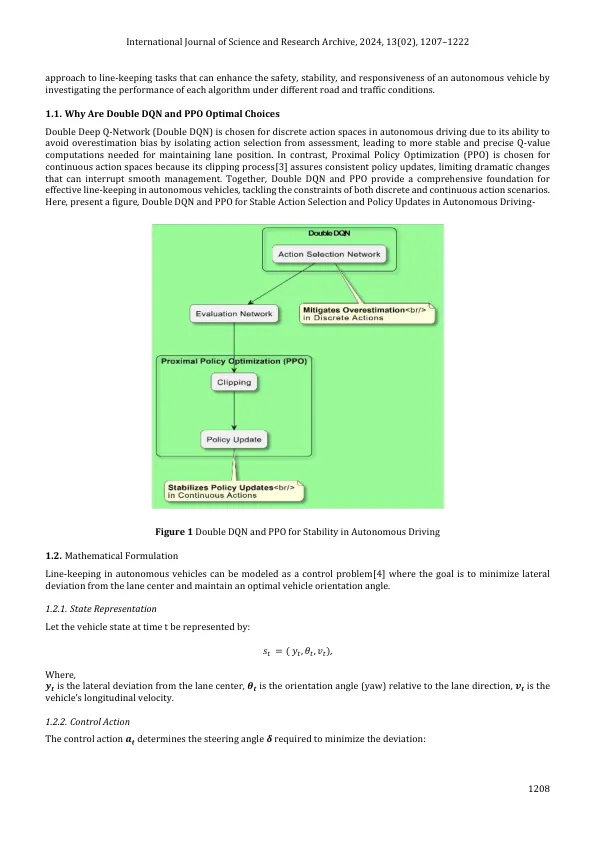

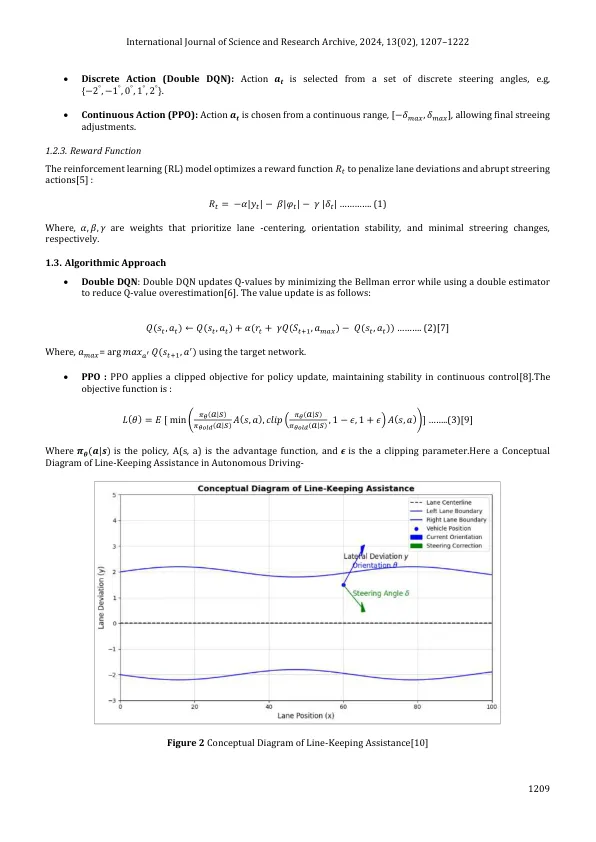

巷道保存是自动驾驶中至关重要的功能,对于车辆安全,稳定性和遵守交通流量很重要。巷道控制控制的复杂性在于平衡各种驾驶环境的精确性和响应能力。本文对两种强化学习(RL)算法进行了比较检查 - Double Deep Q-Network(Double DQN)和近端策略优化(PPO) - 用于跨离散和连续动作空间的车道。double dqn是对标准深q网络的升级,消除了q值的高估偏差,证明了其在离散作用空间中的有用性。这种方法在高维环境(如高速公路)等低维环境中发光,在该环境中,车道保存需要经常进行离散的修改。相比之下,PPO是一种用于连续控制的强大政策梯度方法,在高维情况(例如城市道路和弯曲的高速公路)中表现良好,在这种情况下,必须进行持续的,准确的转向变化。在MATLAB/SIMULINK模拟中测试了这些方法,以模拟高速公路和城市驱动环境。每个模型都集成了车辆动力学和神经网络拓扑以构建控制技术。结果表明,双DQN始终保持在高速公路设置中的车道位置,从而利用了其最小化Q值高估的能力,从而达到了稳定的车道居中。ppo在动态和不可预测的设置中超出了持续的控制调整,尤其是在困难的交通状况和弯曲道路上。这项研究强调了将RL算法与特定驾驶环境的动作空间要求相匹配的重要性,在离散任务方面具有双重DQN,并且在连续自适应控制方面具有出色的DQN和PPO,从而有助于提高自主汽车的灵活性和安全性。

双重Q网络的比较分析(...

主要关键词