机构名称:

¥ 1.0

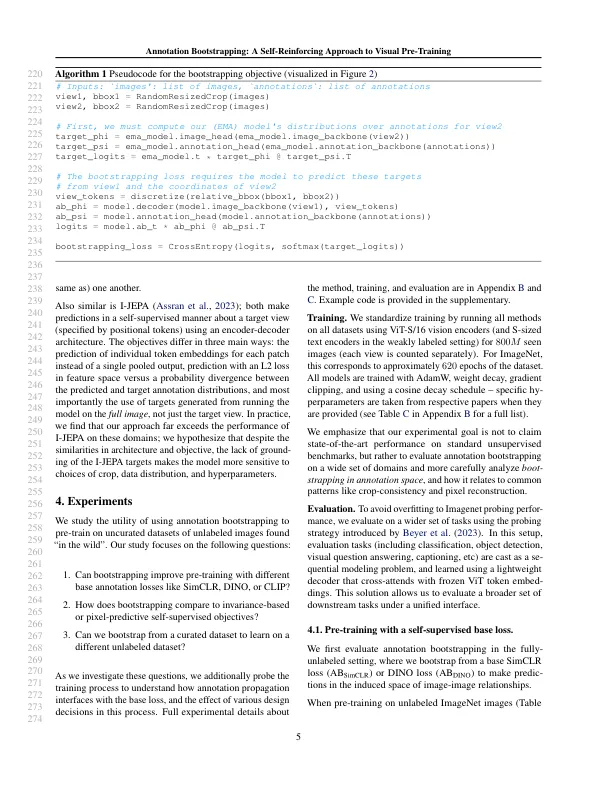

尽管在野外有大量未标记的图像,但在原始图像数据上进行了可扩展的视觉预训练仍然是一个挑战。像素重建之类的通用配方努力为有效捕获详细的语义而努力,而在增强图像视图之间保持一致性的方法优化依赖于未经保育数据(如Web Crawls或视频框架)中不存在的归纳偏见。我们如何从广泛的未标记的IMEAL数据集中更有效地学习?我们研究注释引导程序,这种方法学会了将图像关联到示意注释,并使用未标记的数据来引导模型的理解,通过对图像附近农作物的语义进行预测。关键的优势在于它具有规格(哪些语义概念很有趣?)从预测中(这些概念发生在自然图像数据中?)。我们表明,注释引导使我们能够通过策划的未标记数据集或弱监督的数据集指导预训练,同时通过自举损失从所有未经切割的图像数据中学习。我们的实验证明了对野外未标记图像的预先培训的改进,包括视频数据,例如epickitchens,Coco等场景数据以及CC12M(例如CC12M)。

注释引导:一种自我增强方法的视觉预训练

主要关键词