机构名称:

¥ 2.0

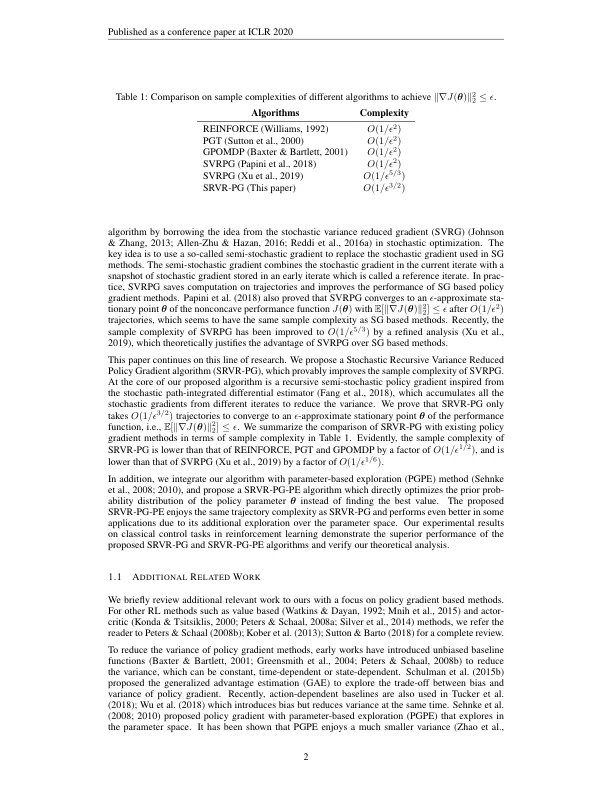

提高增强学习的样本效率一直是一个长期的研究问题。在这项工作中,我们旨在降低现有策略梯度方法的样本复杂性。我们提出了一个称为srvr-pg的新型策略梯度算法,它仅需要o(1 / ϵ3 / 2)1个情节才能发现非循环性能函数的近似固定点j(θ)(即,即θ,θ,θ,以便∥∇j(θ)∥∇j(θ)∥22 fule untoct此样本复杂性改善了现有的结果O(1 / ϵ5 / 3)对于随机方差,策略梯度算法降低了O(1 / ϵ1 / 6)。此外,我们还提出了一个带有参数探索的SRVR-PG的变体,该变体从先前的概率分布中探索了初始策略参数。我们就加强学习的经典控制问题进行数值实验,以验证我们提出的算法的性能。

样本有效的策略梯度方法

主要关键词