机构名称:

¥ 1.0

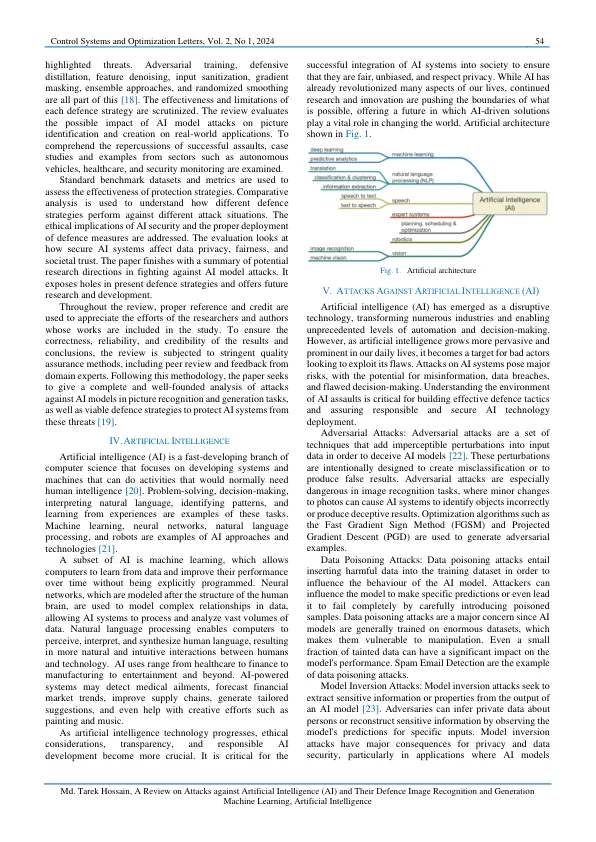

摘要 —本文的主要目的是回顾对抗性攻击、数据中毒、模型反转攻击以及其他可能危及基于人工智能的图像识别和生成模型的完整性和可靠性的方法。随着人工智能 (AI) 系统在众多领域越来越受欢迎,它们易受攻击的问题已成为一个主要问题。在我们的回顾研究中,我们重点关注针对用于图片识别和创建任务的人工智能模型的攻击。我们研究了各种攻击策略,包括传统和更复杂的技术。这些攻击利用了机器学习算法中的缺陷,经常导致错误分类、伪造图片或未经授权访问敏感数据。我们调查了学者和从业者为克服这些困难而开发的许多防御策略。这些防御措施包括对抗性训练、强大的特征提取、输入清理和模型提炼。我们探讨了每种保护机制的实用性和局限性,强调了综合方法的重要性,该方法整合了多种技术来提高人工智能模型的弹性。此外,我们还研究了这些攻击对无人驾驶汽车、医学成像系统和安全监控等实际应用的可能影响,强调了对公共安全和隐私的威胁。该研究还涵盖了人工智能安全的立法和道德方面,以及人工智能开发人员在建立充分防御措施方面的责任。为了保护训练人工智能模型所需的敏感数据,请将数据隐私和安全放在首位。在创建人工智能模型时,请考虑对抗鲁棒性。定期对模型进行对抗性攻击以发现弱点并应用防御策略(如对抗性训练)来增强模型对恶意输入的抵抗力。这项分析强调了持续研究和合作的迫切需要,以开发能够抵御复杂攻击的更安全的人工智能系统。随着人工智能的发展和融入重要领域,必须齐心协力加强这些系统对敌对威胁的抵御能力,并确保它们负责任地部署以造福社会。

回顾针对人工智能 (AI) 的攻击以及......

主要关键词