机构名称:

¥ 1.0

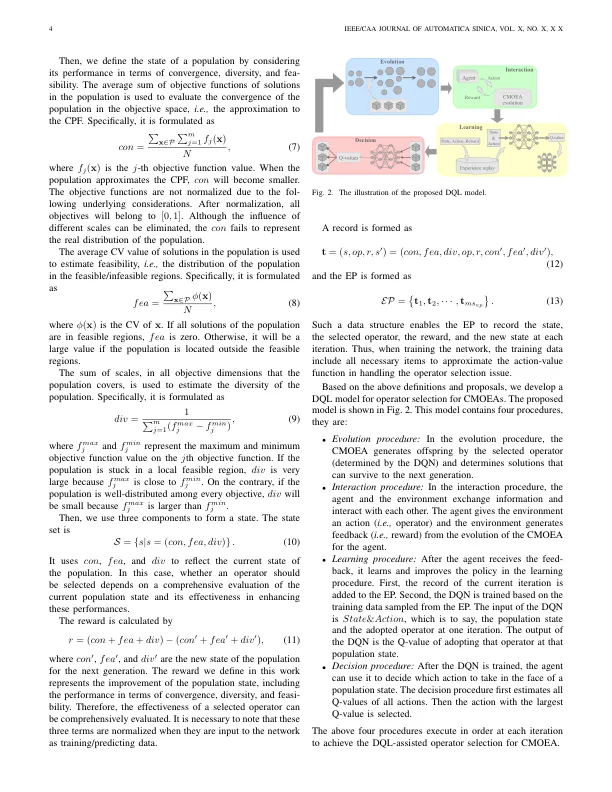

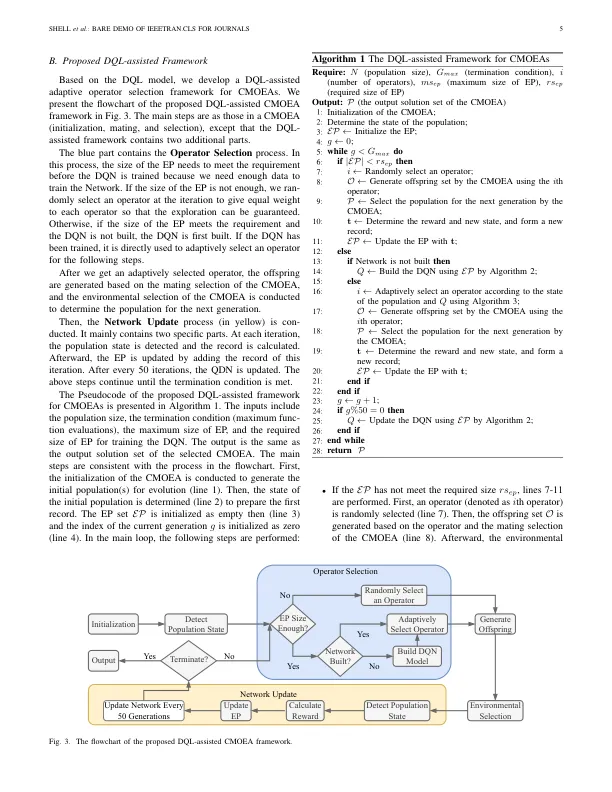

摘要 - 分解有限的多目标优化问题,其进化算法引起了相当大的关注。使用不同的算法策略,进化运算符和约束处理技术,已经开发出各种受约束的多目标优化算法(CMOEAS)。CMOEA的性能可能很大程度上取决于所使用的操作员,但是,通常很难为当前的问题选择合适的操作员。因此,改善操作员的选择是有希望的,对于CMOEAS来说是必要的。这项工作提出了一个在线操作员的选择框架,并在深入的强化学习中有助于。人口的动态,包括融合,多样性和可行性,被视为国家;候选运营商被视为行动;人口状态的改善被视为奖励。通过使用Q-Network学习策略来估计所有动作的Q值,建议的方法可以适应地选择一个操作员,该操作员根据当前状态最大程度地提高人口的改善,从而改善算法性能。该框架嵌入了四个流行的CMOEAS中,并在42个基准问题上进行了评估。实验结果表明,与九个最先进的CMOEA相比,提出的深钢筋学习辅助操作员的选择显着提高了这些CMOEAS的性能,并且所得算法获得了更好的多功能性。

通过深钢筋学习辅助操作员选择的受约束多目标优化

主要关键词