机构名称:

¥ 3.0

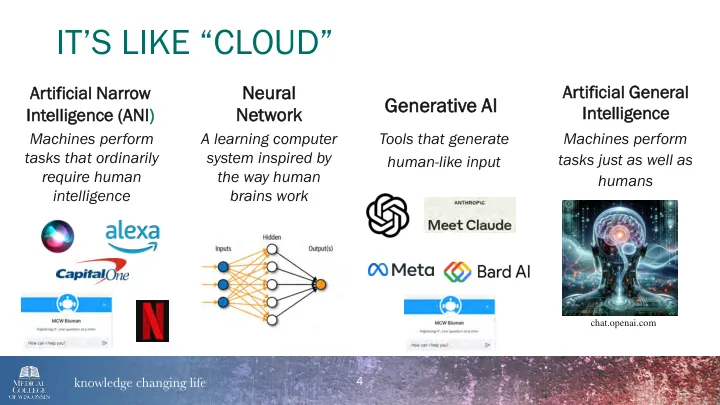

• 由文本驱动 • 在公共互联网上进行预训练(2022 年 1 月*) • 非监督和超可扩展 • 学习底层结构和模式 • 更多训练数据,更好的输出 • Transformers 权衡单词序列的重要性并预测下一个单词 • 使用来自人类反馈的强化学习 (RLHF) 进行微调 • 流行与准确

了解健康科学教育中的人工智能