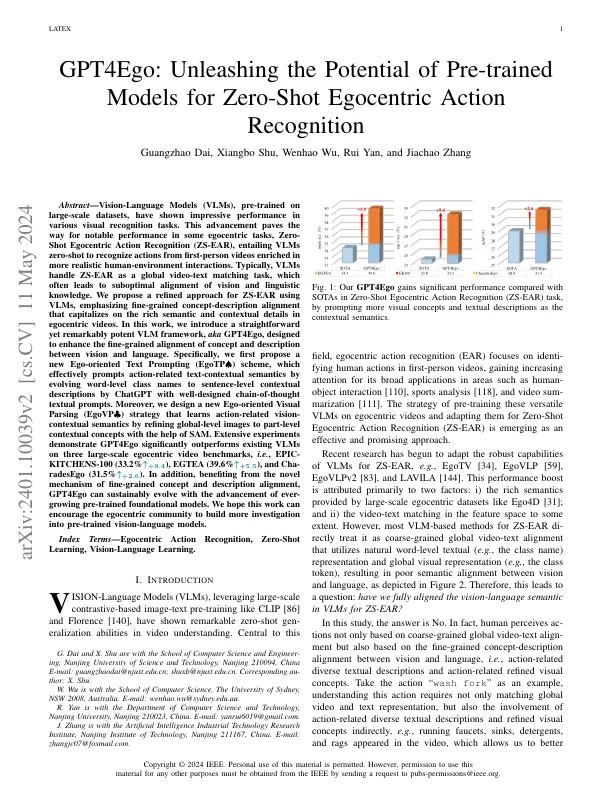

摘要 - 在大规模数据集上进行训练的Vision语言模型(VLMS)在各种视觉识别任务中表现出令人印象深刻的性能。这一进步为某些以自我为中心的任务,零射击以自我为中心的行动识别(ZS-EAR)的表现为著名的表现铺平了道路,这需要VLMS零射击,以识别从更现实的人类环境相互作用中富含第一人称视频的动作。通常,VLM将ZS-EAR作为全球视频文本匹配任务处理,这通常会导致视觉和语言知识的次优比对。我们提出了一种使用VLM的Zs-Ear的精致方法,强调了精细元素概念 - 描述对准,该对齐利用了以Egintric视频中丰富的语义和上下文细节来利用。在这项工作中,我们引入了一个直接但有效的VLM框架,即aka gpt4ego,旨在增强视觉和语言之间的概念和描述的细粒度对齐。具体来说,我们首先提出了一个新的面向自我的文本提示(EGOTP♠)方案,该方案通过将单词级别的类名与良好设计的链条链接的链中的文本提示提示,通过将单词级别的类名为句子级别的上下文描述来有效提示与动作相关的文本上下文语义。此外,我们设计了一种新的面向自我的视觉解析(EGOVP♣)策略,该策略通过在SAM的帮助下将全球级别的图像改进到部分级别的上下文概念来学习与动作相关的视觉 - 上下文语义。广泛的实验证明了GPT4EGO在三个大规模的以egintric视频基准上的表现明显优于现有的VLMS,即,Epic- Kitchens-100(33.2%↑+9。4),EGTEA(39.6%↑+5。 6)。4),EGTEA(39.6%↑+5。6)。5)和Cha-Radesego(31.5%↑+2。此外,从新颖的细粒概念和描述对齐的新机制中受益,GPT4EGO可以通过不断发展的预培训的基础模型的发展来可持续发展。我们希望这项工作可以鼓励以自我为中心的社区对预训练的视觉模型进行更多调查。

释放预先训练模型的零...

主要关键词